Tabla de contenidos

Qué es el Meta Robots y para qué sirve

Las directivas meta robots o «meta etiquetas» son piezas de código HTML situadas en la cabecera de una página que se encargan de proporcionar a los buscadores instrucciones precisas sobre cómo deben rastrear e indexar el contenido de dicha URL.

Es decir, le indican a Google y otros buscadores si debe o no indexar el contenido de la página en cuestión y si debe o no rastrear los enlaces que haya en esta página.

Dónde y cómo se implementa la meta etiqueta Robots.txt

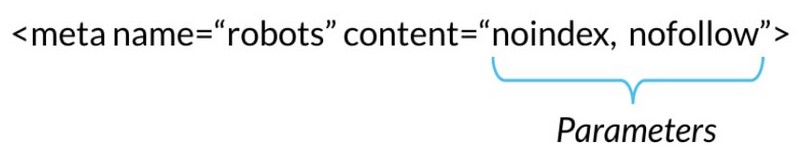

La etiqueta meta robots se debe colocar en el área de encabezado de la página web en cuestión y debe incluir dos atributos: name y content para que funcione de manera adecuada.

Atributo "name"

El atributo name indicará los rastreadores a los que se aplica.

Atributo "content"

El atributo content indicará cómo debe comportarse en función de los parámetros utilizados.

Ejemplo de Meta Etiqueta

A continuación mostramos un ejemplo de meta etiqueta:

meta name="robots" content="noindex" />

<meta name="googlebot" content="noindex" />

<meta name="googlebot-news" content="noindex" />

<meta name="slurp" content="noindex" />

<meta name="msnbot" content="noindex" />

Parámetros de control de indexación

- Index: Sugiere a un motor de búsqueda que indexe una página.

- Noindex: Indica a un motor de búsqueda que no indexe una página.

- None: Equivale a emplear ambas etiquetas noindex y nofollow.

- Noimageindex: Indica a un rastreador que no indexe ninguna imagen de una página.

- Follow: Aunque la página no esté indexada, indicamos al bot seguir todos los enlaces que encuentre traspasando el link juice a las páginas enlazadas.

- Nofollow: Indica al rastreador que no siga ningún enlace de la página en cuestión ni tampoco pasar ningúna autoridad de página a través de esos enlaces.

- Noarchive: sugiere a los motores de búsqueda no mostrar la versión en caché de la página en cuestión.

- Nocache: Igual que noarchive, pero sólo lo utilizan Internet Explorer y Firefox.

- Nosnippet: sugiere a los buscadores no mostrar los fragmentos enriquecidos de esa página en los resultados de búsqueda.

- Unavailable_after: Los motores de búsqueda ya no deben indexar esta página después de una fecha determinada.

Directivas para los diferentes buscadores

Sin embargo, no todos los buscadores admiten todas las directivas:

| Value | Bing | Yandex | |

|---|---|---|---|

| index | ✔️ | ✔️ | ✔️ |

| noindex | ✔️ | ✔️ | ✔️ |

| none | ✔️ | ❌ | ✔️ |

| noimageindex | ✔️ | ❌ | ❌ |

| follow | ✔️ | ✔️ | ✔️ |

| nofollow | ✔️ | ✔️ | ✔️ |

| noarchive/nocache | ✔️ | ✔️ | ✔️ |

| nosnippet | ✔️ | ❌ | ❌ |

| notranslate | ✔️ | ❌ | ❌ |

| unavailable_after | ✔️ | ❌ | ❌ |

Ejemplo de uso e interpretación de directivas

Los parámetros más comunes que vamos a encontrar y útiles de cara al SEO son la etiqueta index, etiqueta noindex, etiqueta follow y la etiqueta no follow:

Esta meta está sugiriendo al Googlebot y demás rastreadores que indexen el contenido para incluirlo en sus listados y que sigan todos los enlaces que encuentren en esta URL.

Por defecto cuando no hay ninguna meta robots indicada en la URL esta es la instrucción que todos los bots sobre entienden al rastrear cualquier URL. Así que no es necesario incluirla para facilitar que se indexen tus contenidos.

En este caso lo que le indicamos al buscador es que no indexe la URL en cuestión y que por lo tanto no se presente en los resultados del buscador pero que si siga los enlaces que encuentre en el rastreo de la página.

Solemos usarla con páginas con poco valor para el usuario pero que contiene enlaces que nos interesa que siga el buscador para llegar a otras secciones de nuestra web.

La metaetiqueta “noindex, nofollow” sugiere a los motores de búsqueda que no indexen la página y que además no sigan los enlaces que se encuentren en ella.

¿Cuándo usar esta directiva?

Generalmente cuando el contenido de la página no aporta ningún valor y no queremos que siga los enlaces que encuentre en el contenido.

Aquí, le estamos sugiriendo a los buscadores que incluyan el contenido en su base de datos pero que no sigan los enlaces que encuentren en el contenido de la URL en cuestión.

Tipos de etiquetas Robots

Hay dos tipos de meta robots:

- Las Meta etiquetas robots: que forman parte de la página html situadas en el sección <head>

- Las X-robots-tag: enviadas por el servidor web como cabeceras HTTP

En ambos casos funcionan los mismos parámetros e instrucciones de rastreo o indexación.

Los parámetros «noindex» y «nofollow» pueden utilizarse tanto con meta robots como con la etiqueta x-robots.

Lo que difiere es la forma en que esos parámetros se comunican a los rastreadores.

En concreto, la etiqueta x-robots permite el uso de expresiones regulares, la ejecución de directivas de rastreo en archivos no HTML y la aplicación de parámetros a nivel global no solo de URL.

Nota: No es necesario utilizar los meta robots y la etiqueta x-robots en la misma página, ya que es redundante.

Por qué son importantes

Este tipo de directivas junto al archivo robots.txt, las etiquetas canonicals y el X-robots-tag permiten controlar la indexabilidad y rastreo de tu sitio web.

De ahí su importancia:

Dado que permiten indicar a los buscadores a nivel individual que debe ignorar y que no a la hora de incluirlo en su index y qué contenidos son relevantes o prioritarios.

Así, conseguimos optimizar el presupuesto de rastreo y evitar errores de contenido duplicado.

A continuación, te indicamos los parámetros que los rastreadores de los motores de búsqueda entienden y siguen cuando se utilizan en las meta directivas de los robots:

Diferencias entre Meta robots vs. Robots.txt

La principal diferencia entre ellos es que las meta robots dan indicaciones sobre la indexación de las páginas, mientras que el robots.txt da indicaciones sobre el rastreo.

Es decir, el robots.txt da instrucciones válidas para indexar y crawlear secciones enteras de un dominio como por ejemplo: categorías, subcarpetas y archivos

Por ejemplo:

Así, conseguimos optimizar el presupuesto de rastreo y evitar errores de contenido duplicado.

Si indicamos a nivel de robots.txt que una categoría no debe ser rastreada pero las URLs que forman parte de esa categoría tienen la etiqueta index porque las queremos indexar, Googlebot no podrá acceder a ellas por estar bloqueadas y es muy difícil que las indexe.

Recomendaciones SEO para la aplicación del Meta Robots

Todas las meta directivas (robots o de otro tipo) se descubren cuando se rastrea una URL.

Esto significa que si un archivo robots.txt no permite el rastreo de la URL, cualquier meta directiva en una página (ya sea en el HTML o en la cabecera HTTP) no se verá y será, efectivamente, ignorada.

En la mayoría de los casos, se debe utilizar una etiqueta meta robots con los parámetros «noindex, follow» como forma de restringir el rastreo o la indexación en lugar de utilizar la desautorización del archivo robots.txt.

En conclusión:

Las meta etiquetas o meta robots son un gran instrumento para controlar la indexación y rastreo de nuestro sitio web.

Utilizarlos de la manera correcta junto con el archivo robots.txt, las canonicals, la arquitectura web, etc, es fundamental para asegurar la optimización del crawl budget y facilitar el trabajo de los buscadores así como un correcto traspaso de la autoridad mediante enlazado interno.

Recuerda que las meta robots actúan a nivel de URL.

Importante: Es importante señalar que al igual que ocurre con los archivos robots.txt, los rastreadores no están obligados a seguir las instrucciones indicadas por las metatags de tu página. Actúan solo a modo de sugerencia.

Preguntas Frecuentes

¿Qué método debo utilizar para bloquear rastreadores?

Dependiendo del caso estas son las 3 maneras diferentes de bloquear al Googlebot:

- Robots.txt: Utilízala si el rastreo de tu contenido está causando problemas en el servidor o para bloquear secciones de la web que no queremos publicar en el index de Google como la página de credenciales de acceso a la administración de tu sitio web. Eso sí, no utilices el robots.txt para bloquear contenido privado (utiliza en su lugar la autenticación del lado del servidor), ni tampoco para gestionar la canonización.

- Etiqueta meta robots: Utilízala si necesitas controlar cómo se muestra una página HTML individual en los resultados de búsqueda.

- Cabecera HTTP X-Robots-Tag: Utilízala si necesitas controlar cómo se muestra el contenido en los resultados de búsqueda sólo cuando no puedas usar las etiquetas meta robots o quieras controlarlas a través del servidor.

¿Cuando usar Meta Robots en vez de Robots.txt?

Las etiquetas meta robots deben usarse siempre que queramos controlar la indexación a nivel de página individual. Es decir para asegurar que una URL no se indexa, utiliza siempre la metaetiqueta robots o la cabecera HTTP X-Robots-Tag.

Enlaces y lecturas recomendados

- Moz. (2022, 2 junio). What Are Robots Meta Tags? Learn Technical SEO. Moz. https://moz.com/learn/seo/robots-meta-directives

- Tutoríal + Guía de las etiquetas meta robots y SEO. (2019, octubre 12). Seoandcopywriting.com. https://seoandcopywriting.com/meta-robots-seo-guia/

- Crear y enviar un archivo robots.txt. (s/f). Google Developers. Recuperado el 5 de enero de 2023, de https://developers.google.com/search/docs/advanced/robots/create-robots-txt?hl=es