Hola familiares y amigos, primero de todo agradecer la acogida de la iniciativa, un placer poder compartir con todos esta experiencia.

Para todos los que no lo sepan, esta iniciativa surgió a raíz de la compra de un proyecto para nuestra sección de proyectos propios y la explicación es básicamente este tweet:

.

Y este linkedin:

En este post vamos a ir contando los pasos y acciones que vamos a ir haciendo en el proyecto para intentar recuperar el proyecto y sacarle rentabilidad al mismo. Será un post que iremos actualizando con las acciones y avances o retrocesos 😉

Como puntualización decir que no vamos a decir la url ni temática del proyecto, pero sí vamos a dar bastante información de todo el proceso. Esto es así, porque no queremos que influyan factores externos, para evitar ataques de SEO Negativo y por respeto a la anterior empresa que llevaba el proyecto, ya que sacaremos deficiencias y estamos aquí para aprender y disfrutar y no para hacer sangre. Dicho todo esto AL TURRON!!

Vamos por partes…

SEMANA 1: Análisis inicial

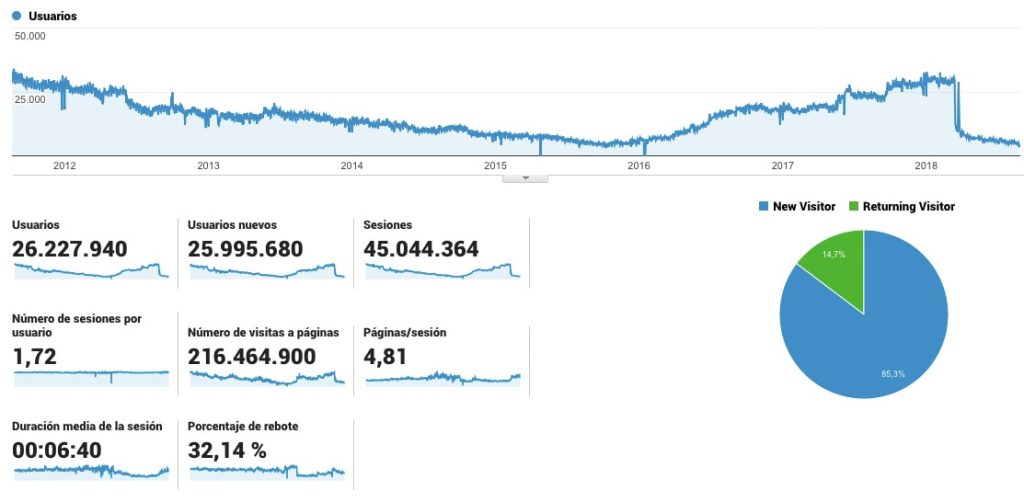

Antes de comprar el proyecto hicimos una preauditoría para ver las posibilidades que tenía el nicho, así como el estado del proyecto y posibilidad de recuperación del mismo. Además de esto miramos los recursos y valor que podíamos aportar al mismo.

¿Cual es el estado del proyecto y qué hemos hecho hasta ahora?

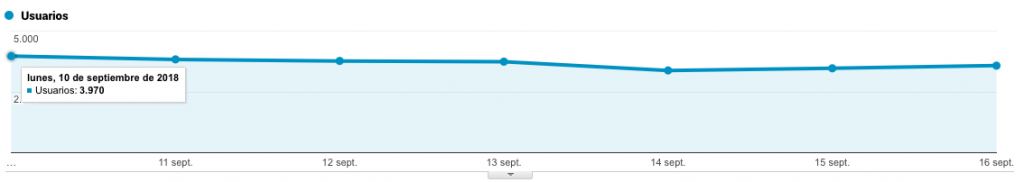

y si segmentamos sólo por tráfico SEO, veréis que la visión no es mucho más optimista, va cuesta abajo y sin frenos!

¿Alguien dijo miedo? Nooooooo nos encantan los retos.

Enlaces

En este análisis como hacemos siempre tiramos de un análisis de enlaces con Ahrefs. El dominio está dividido entre dominio y subdominio. El dominio tiene una mayor autoridad como veis aquí:

Ojo cuidao que tiene enlaces de SEO Negativo, pero no es una locura. Luego por otro lado está el subdominio que es de donde cuelga el proyecto con más valor SEO y el proyecto que vamos a trabajar como tal, que tiene el siguiente perfil de enlaces.

No es un perfil de enlaces muy desastroso, tampoco es una maravilla pero se puede trabajar con él, y además da pie a poder hacer acciones interesantes.

Contenidos

En este punto siempre nos apoyamos en los amigos de safecont (un abrazo!).

Cuando analizamos inicialmente cualquier proyecto, antes hacemos una revisión de la calidad del contenido con la herramienta, sobre un muestreo del total de urls del proyecto. Esto nos permite detectar fácilmente patrones y deficiencias claras en el contenido.

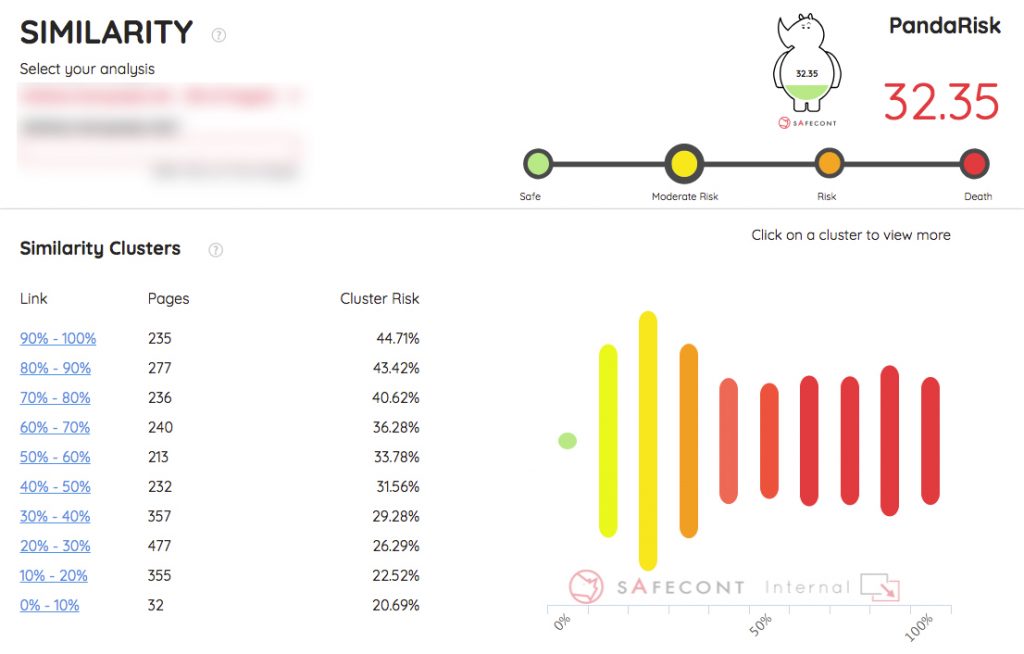

Si estáis familiarizados con la herramienta podéis ver que el índice de peligrosidad del proyecto no es grande, pero estos datos se tienen que coger con conocimiento del nicho y la tipología de página. Si tú analizas un proyecto donde en el nicho es normal el thincontent, por ejemplo web de gifs con un pequeño texto. Ahí puedes tener un índice de peligrosidad enorme y no ser preocupante.

En este caso puntual, es una web de contenidos, donde la competencia tiene mucho contenidos, y aquí un valor como este sí es un punto a tener en cuenta y optimizar.

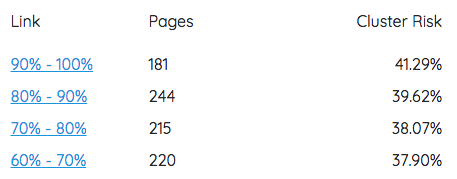

Aquí os dejamos la gráfica del mismo tomada sobre el muestreo inicial:

Como podéis ver tenemos un número importante de agrupaciones de páginas con una tasa de similaridad elevada (el mayor problema de este proyecto a nivel de contenidos).

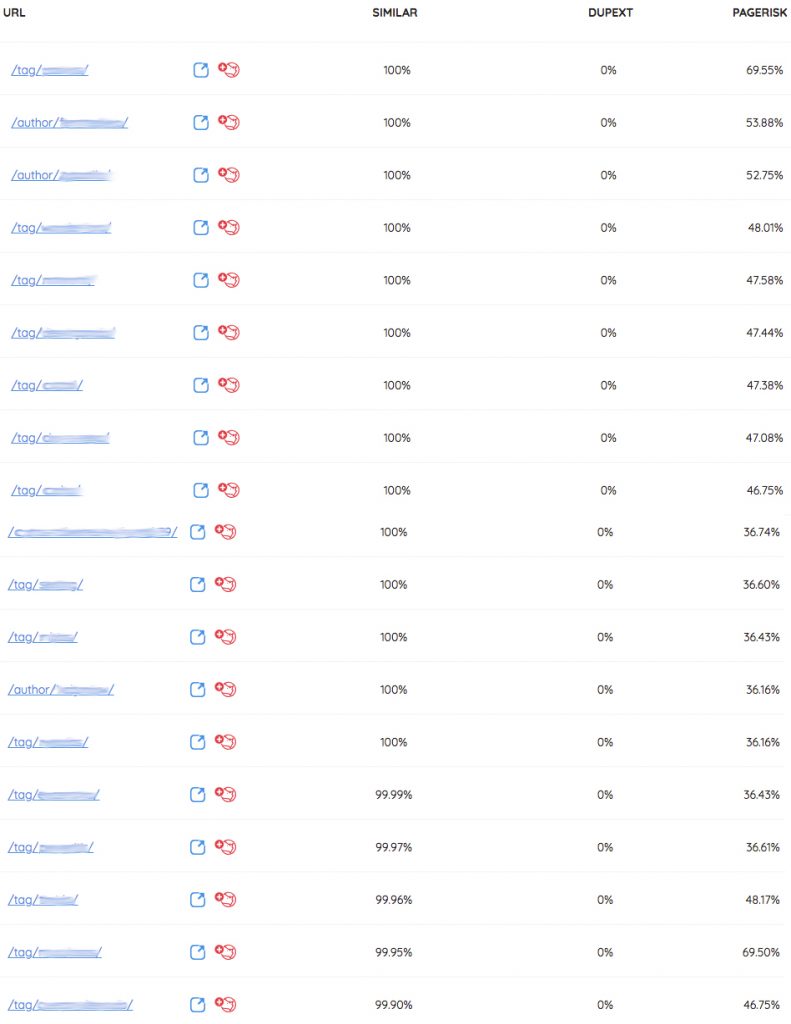

En este punto es el momento de buscar y analizar patrones que estén generando este problema. Y la verdad es que ha sido bastante fácil, como podéis ver vosotros mismos:

Como podéis ver hay dos tipologías que están generando un gran problema que son las TAGS y las páginas de AUTHOR.

Esto es super común en las webs informativas y más si tienen una comunidad de usuarios como es el caso, donde permiten a los propios usuario poner las tags como les de la gana.

Escrapeo y detección de deficiencias SEO Básicas

En este punto usamos dos herramientas que nos facilitan mucho el trabajo. Primero nuestra querida rana Screaming Frog para ver las deficiencias más básicas, así como volumen de urls rastreables… posteriormente para un análisis más en profundidad nos apoyamos en FandangoSEO (besicos Victor! esa MafiaSEO), para hacer una análisis más en profundidad, cruzando logs y ingiriendo datos para poder sacar información de más calidad.

En este punto detectamos muchas deficiencias básicas como: 404, 301, ausencia de titles y metas optimizados… Vamos que el proyecto tiene trabajo.

Pero el punto más relevante es el volumen de URLs Rastreables VS URLs en en los resultados de google. Como podéis ver en la siguiente captura hay una disparidad enorme en este punto.

Primeras acciones SEO

Esta semana es un poco de locos, porque es cierre de mes y tenemos informes en la agencia, además de reuniones y mil historias, así que tenemos que optimizar los tiempos y hacer acciones que tengan desde nuestro punto de vista una gran repercusión en poco tiempo y con poca dedicación.

Es por esto que las primeras acciones han sido de sacar las tijeras y ponerse a podar:

Desindexación de páginas de alta similaridad y bajo aporte de valor SEO:

Después de hacer el preanálisis de contenidos vimos que las URLs del tipo TAGS, AUTHOR y PAGES, estaban generando unos problemas importantes de similaridad de contenidos. Tras esto lo que hicimos fue cruzar estos datos junto con enlaces entrantes a estas urls, tanto internos como externos y además sacar las keys que podían tener posicionadas y el tráfico orgánico que recibían estas urls.

Como ya nos esperábamos todas estas tipologías de URLs no tienen tráfico orgánico y no con más que contenedores que no aportan valor a la estrategia.

Así que en este punto pasamos a desindexar todas las URLs de TAGS, Autores y paginaciones. Muchos os preguntaréis por qué desindexamos las paginaciones. Básicamente con un rel next y prev debería ser suficiente, pero es que no está bien implementado y hay indexada mucha mierda en este tipo de páginas, así que hemos preferido limpiar y seguir avanzado.

Aquí un punto importante, desde alguna de las últimas actualizaciones de Yoast, no es posible desindexar las paginaciones desde el backend y hay que hacerlo por programación. Para quien lo necesite, aquí dejamos el código a añadir en el function.php de wordpress para desindexar las paginaciones:

// noindex,follow en paginaciones de paginas

add_filter(‘wpseo_robots’, ‘yoast_no_home_noindex’, 999);

function yoast_no_home_noindex($string= «») {

if (is_paged()) {

$string= «noindex,follow»;

}

return $string;

}

Ojito con esto. Después de implementarlo si lo usáis, revisar que no os desindexe nada que no queráis. Pasar algún escraper por la web después de implementarlo para revisar que está todo OK.

Tras la desindexación lo que hicimos fue crear un sitemap con todas estas urls y subirlo a GSC. Para ello puedes usar por ejemplo: http://www.timestampgenerator.com/tools/xml-sitemap-from-list/

Aquí sacáis las urls con la rana, filtráis por tipología, se pasa a un excel y de ahí a esta herramienta y se monta un sitemap.

Correcciones de código y enlaces innecesarios

El theme que tiene actualmente la web, hace cosas como ocultar enlaces y Hs con display:none y maravillas similares, así que hicimos unas pequeñas modificaciones en el código para quitar este tipo de chapuzas, al menos hasta que cambiemos el theme. Además quitamos los enlaces en secciones principales hacia las tags y los usuarios, reduciendo el link juice que pasamos a estas páginas carentes de valor SEO.

El plugin del mal. WP-Touch

No sé si algun@ conoce el plugin de WP-Touch. Bien, este plugin lo que hace es convertirte la web en una especie de APP para mejorar la navegabilidad por el proyecto y con ello la experiencia de usuario. Hasta aquí cojonudo pero… y el SEO?

Claro, si esto no lo haces bien, el problema que tienes es que la web en versión mobile en todas las categorías y secciones únicamente muestra un listado de enlaces a los artículos y esto con Mobile First es una fiesta!

Derivado de esto generas que las páginas que deberían tener un mayor valor de SEO como son las categorías únicamente tengan como contenido un puñado de links y por ende thincontent y similaridad a espuertas.

Así que evidentemente quitamos este plugin y además tocamos el código de la web para que mostrar de cada contenido el extracto del post y genera algo más de contenido en las categorías. Esto evidentemente es sólo el paso 1.

Planificación de acciones futuras

Ahora que ya sabemos cómo está el proyecto a grandes rasgos toca escarbar y empezar a sacar todo lo que hay debajo de esta capa superficial, para ello hemos creado un listado de acciones que nos repartiremos entre los 3 SEOs que vamos a llevar el proyecto. Saludos a Marcos y Roger 😉

El listado de tareas que hemos marcado en este sprint son las siguientes:

– Auditoria

– Análisis del problema de indexación

– Keyword research y elaboración de titles+metas

– Auditoría de links y desindexación de enlaces

– Eliminación de las SERPs de URLs desindexadas

– Elección del nuevo Theme

– Elaboración de plan de acciones de blackhat con redes sociales

– Inyección de tráfico cualificado (tras optimización y migrado al nuevo servidor y con el nuevo theme)

– Análisis de CTRs + Mejoras de titles y metas (Tras cargar los titles y un tiempo de revisión)

– Preparación del servidor y nuevo entorno

– Preparar la migración del entorno con los redirects

Estos deben ser los siguientes pasos a hacer con el proyecto. Y en los próximos días queremos abarcar:

– Auditoria

– Preparación del servidor y nuevo entorno

– Preparar los redirects de URLs actuales a finales

– Elección del nuevo theme, instalación y configuración

– Análisis del problema de indexación

– Keyword research y titles+metas. Esto derivará también en la creación de la nueva arquitectura

Bueno y esto es todo por esta semana, esperamos que nos dejéis vuestro comentarios y aportaciones, así como cualquier duda.

SEMANA 2: Plan de Acción

Llegamos a la segunda semana de trabajo y en este caso hemos tenido una semana bastante movidita, por lo que no hemos podido acabar todas las tareas que nos habíamos propuesto. La razón principal es que tuve que viajar a Portugal a principio de semana para cerrar nuestro primer Exit de proyectos propios, como muchos pudísteis leer por twitter y esto nos descuadró bastante toda la semana.

Bueno, dicho todo esto vamos al turrón.

¿Qué acciones hemos hecho?

– Auditoria ✅

– Preparación del servidor y nuevo entorno ✅

– Preparar los redirects de URLs actuales a finales ❌ (Depende del Keyword Research que lo tenemos a medias)

– Elección del nuevo theme, instalación y configuración ❌ (Tenemos un problema de rendimiento del theme con tanto volumen de publicaciones)

– Análisis del problema de indexación ❌

– Keyword research y titles+metas. Esto derivará también en la creación de la nueva arquitectura ❌ (La tenemos a medias)

Punto añadido:

– Análisis de URLs que están generando problemas de similaridad al detalle y planteamiento de acciones ✅

Como podéis ver ha sido una semana bastante FAIL en cuanto a acciones.

¿Estado del proyecto en la segunda semana?

Es importante tener en cuenta que algunas de las acciones que se hicieron durante la primera semana repercutían sobre muchas de las URLs actuales. La desindexación de URLs (que en una segunda fase pasarán a ser 301 en muchos casos) afectó al 25% de las URLs totales, por poner un ejemplo. También la supresión del plugin de WP-Touch cambió toda la arquitectura a nivel móvil y a nivel de contenidos.

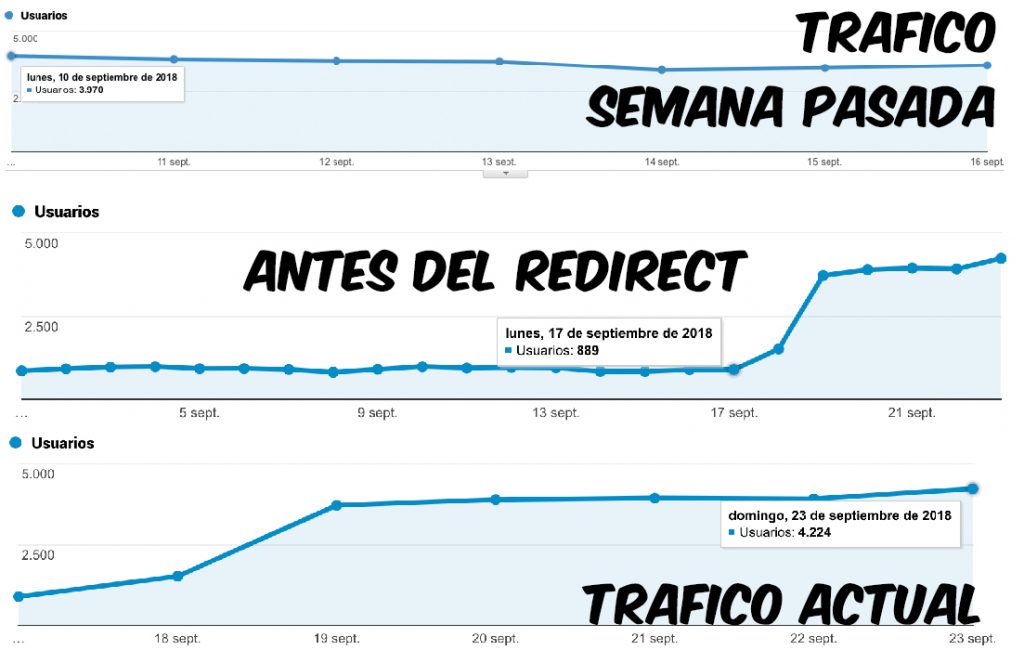

El proyecto parece que está estabilizando el tráfico en esta primera semana, pero todavía es pronto para dibujar una tendencia.

Estas acciones son acciones que requieren de un tiempo para ver resultados.

En el SEO no existe una fórmula mágica e instantánea. Se requiere de tiempo para lograr resultados.

Dicho esto en este primer punto si logramos parar la bajada que está llevando de forma continua el proyecto en las primeras semanas de trabajo, ya será un buen resultado y punto de partida.

Acciones realizadas y evolución

Tras las primeras acciones de desindexación de URLs de bajo valor SEO y alto índice de similaridad y thin content, hemos obtenido los siguientes resultados:

Hemos normalizado bastante el índice de similaridad del proyecto reduciendo con ello el posible riesgo frente a penalizaciones o filtrados derivados de este problema. También hemos reducido la peligrosidad general de safecont en casi 10 puntos, estando ahora en valores mucho más aceptables.

Esto tiene una representación muy clara en la agrupación de URLs más peligrosas. Como podéis ver en la siguiente imagen comparativa, los clusters con más problemas de similaridad han reducido considerablemente el número de urls contenidas en ellos.

¿Cómo vamos a mejorar estos clusters de alta similaridad?

Una vez que hemos hecho la primera criba de URLs paja, queda sacar la lupa e ir al detalle. Para esto hemos seleccionado los clusters que tienen un índice de similaridad superior al 60% (ya que es el principal problema en relación a la calidad de los contenidos) y hemos exportado todas las urls a un excel.

Una vez que tenemos todas estas urls con alto grado de similaridad, vamos a ver si traen tráfico y por ende, si están siendo usadas por los usuarios. Para ello usaremos Screaming Frog conectada con el API de GAnalytics y cruzaremos estos datos con los obtenidos de safecont.

Esto nos genera un listado de posts que tienen poco tráfico o ninguno y que además tienen un índice alto de peligrosidad a ojos de google.

Ya tenemos los datos ¿y ahora qué?

Aquí existen múltiples acciones que se pueden hacer con estos contenidos, como por ejemplo:

- Enriquecer los contenidos que generan similaridad derivada por contener Thin Content

- Unir varios contenidos con Thin Content que están generando similaridad, para generar un contenido único de más calidad y menos similaridad.

- Eliminar contenidos y redireccionar estas URLs a urls que cumplan una intención de búsqueda similar.

- ….

En este caso al tener casi todos los contenidos un buen volumen de texto y no tener sentido la concatenación de contenidos, la mejor opción pasa por eliminar contenidos irrelevantes y hacer redirect de estas URLs a otras que cumplan las mismas necesidades.

Selección de un nuevo theme

Hemos escogido un nuevo theme para la nueva web, puesto que el actual además de aportar poco valor estético, tenía muchas deficiencias SEO importantes.

¿Cómo seleccionamos un theme para un proyecto?

Cada proyecto tiene una necesidades y requerimientos diferentes, por lo que intentar empatizar con el público que hará uso del entorno es un punto importante.

En este caso el contenido que vamos a mostrar es principalmente texto, por lo que el theme debe ofrecer un contenido limpio y fácil de leer, además de esta forma también destacarán luego más los anuncios que incluiremos para monetizar el site.

Por otro lado un punto importante es el WPO, necesitamos que de base el theme no tenga que tener muchas optimizaciones de rendimiento, sea rápido y sea fácilmente optimizable. Para esto te puedes apoyar en utilidades como https://tools.pingdom.com , https://www.webpagetest.org , https://developers.google.com/speed/pagespeed/insights/ …

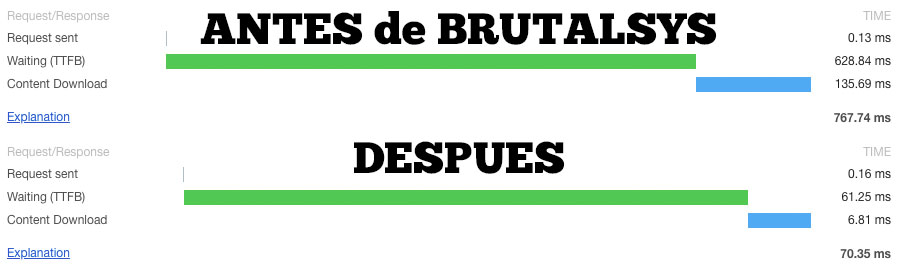

Preparación del servidor

Aquí hemos de decir que lo tenemos fácil ya que trabajamos con el equipo de BrutalSys y ellos se encargan de gran parte de este tipo de tareas. Normalmente en todos nuestros proyectos propios basados en wordpress, tenemos un servidor con NGINX y Varnish, a lo que además le añadimos el plugin de W3 Caché y le configuramos una CDN para servir todos los archivos estáticos. En este caso no ha sido de otra forma, ya que queremos que sea una página de cerca de 50K visitas diarias y los tiempos de carga y el rendimiento es un punto importante.

Planificación de acciones futuras

El listado de tareas que hemos marcado en este sprint son las siguientes:

– Auditoria

– Análisis del problema de indexación

– Keyword research y elaboración de titles+metas

– Auditoría de links y desindexación de enlaces

– Eliminación de las SERPs de URLs desindexadas– Elección del nuevo Theme

– Elaboración de plan de acciones de blackhat con redes sociales

– Inyección de tráfico cualificado (tras optimización y migrado al nuevo servidor y con el nuevo theme)

– Análisis de CTRs + Mejoras de titles y metas (Tras cargar los titles y un tiempo de revisión)– Preparación del servidor y nuevo entorno

– Preparar la migración del entorno con los redirects

Estos deben ser los siguientes pasos a hacer con el proyecto. Y en los próximos 7 días queremos abarcar:

– Eliminación y redirección de URLs con problemas de thin content o similaridad y redirección a URLs con valor SEO.

– Preparar los redirects de URLs actuales a finales

– Configuración y optimización del nuevo theme

– Análisis del problema de indexación

– Keyword research y titles+metas.

– Generación de arquitectura.

SEMANA 3:

Hola de nuevo familiares y amigos, una semana más con el reto iSocialWeb y ya parece que vamos acabando los últimos pasos para poder lanzar en el nuevo entorno y dominio la web casi definitiva. Vamos al lío!!

¿Qué acciones hemos hecho?

Teníamos estas tareas preparadas para esta semana y con la carga de trabajo actual hemos podido realizar las siguientes:

– Eliminación y redirección de URLs con problemas de thin content o similaridad y redirección a URLs con valor SEO. ✅ (aunque haremos una segunda pasada de reoptimización de contenidos)

– Preparar los redirects de URLs actuales a finales ✅

– Configuración y optimización del nuevo theme ✅

– Análisis del problema de indexación ❌

– Keyword research y titles+metas. ✅

– Generación de arquitectura. ✅

Como podéis ver esta semana ha sido más productiva que la anterior hemos acabado casi la totalidad de las tareas, de hecho ya tenemos el entorno prácticamente listo para salir y hacer el cambio de dominio (pasar de subdominio al dominio principal).

Como hay bastantes puntos en las tareas de arriba, vamos a detallar algunos de ellos para que podáis entender mejor las acciones:

Preparar redirects de URLs actuales a finales

Cuando vas a hacer un cambio de entorno, ya sea cambio theme y aun más si es un nuevo dominio con cambio de plantilla como es este caso. Necesitas tener un documento de paridad de URLs, donde tengas claro que las URLs que más tráfico te traen a la web tienen una página homónima en el otro entorno, además de todas las demás, claro está. Esto parece una obviedad pero te encuentras multitud de casos donde no se hace. No es sólo que esa URL tenga una página final sino también:

- Title, H1, H2 y textos: Unos headings en los que al hacer el cambio no se pierda ninguna de las keys que están actualmente posicionadas y que traen tráfico.

- Metadescription: Una meta que siga siendo tanto o más incitadora al click que la anterior. Que no vayamos a perder CTR con el cambio de las metadescripciones.

- Intención de búsqueda: En muchos casos cambiamos un entorno y pasamos, de devolver unos resultados de una forma, a hacerlo de otra, y esta nueva forma puede no estar cumpliendo la intención de búsqueda del usuario de igual forma que lo hacía la anterior. Para ello es bueno monitorizar bien a nivel analítico las URLs principales. Nosotros dependiendo del caso también nos apoyamos también en herramientas como Hotjar o Yandex Metrica para monitorizar a los usuarios y ver cómo interactúan con el nuevo entorno.

Configuración y optimización del nuevo theme:

Aquí lo que hemos hecho es limar todas las deficiencias que podían condicionar la evolución SEO del proyecto por la parte de desarrollo. Entre estas optimizaciones hemos realizado los siguientes cambios:

- Eliminación de recursos estáticos y plugins que no aportaban valor para las necesidades finales del proyecto.

- Generación de una correcta estructura de headings: En casi todos los themes comerciales te encuentras H2, H3 o H4 sin sentido que no aportan lógica a la estructura de headings, además de la posición de los headings principales. En este caso hemos elimiando headings sin sentido y hemos reubicado los principales.

- Implementación de campos personalizados para funcionalidades SEO: Esto lo detallaremos más abajo.

- Optimización de código: Aquí nuestros amigos de BrutalSys le han metido mano al código para optimizar funciones como el contador de visitas en posts, que con flujo grande de tráfico genera problemas de rendimiento.

En referencia a la mejora de rendimiento de la carga, podéis ver un ejemplo de la optimización que realizó Hector de Brutalsys aquí:

Hay que comentar que todavía queda pendiente hasta que lo tengamos en producción habilitar la CDN y alguna optimización más.

Sobre el punto 3 os lo detallamos a continuación:

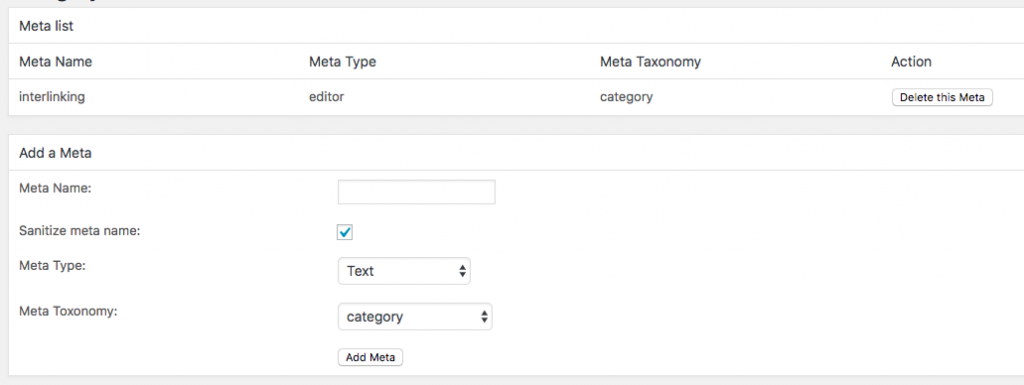

Implementación de campos personalizados:

En muchos casos tenemos la necesidad de, por ejemplo, añadir texto en categoría de posts o de productos, añadir un enlazado especial en determinadas secciones, incluir headings determinados en secciones específicas…

Para todo este tipo de implementaciones en wordpress, nosotros hacemos uso de un plugin que se llama:

LSD Custom taxonomy and category meta

y que podéis encontrar aquí: https://es.wordpress.org/plugins/custom-taxonomy-category-and-term-fields/

Este plugin lo que permite es añadir campos personalizados en las principales tipologías de página en wordpress y luego leerlos por código volcando el dato.

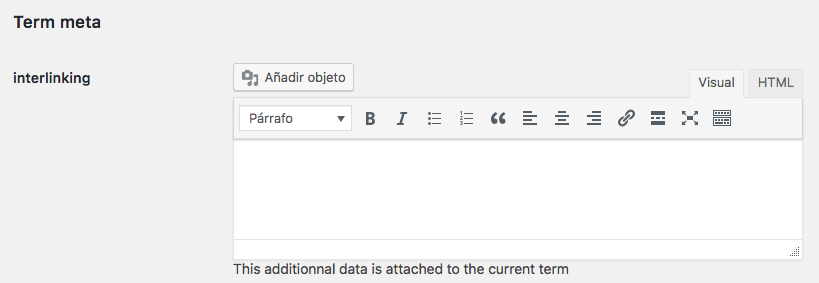

En este caso hemos hecho uso de este recurso para implementar en las categorías dos mejoras:

- Una estrategia de enlazado acorde a la arquitectura buscando optimizar el CTR interno entre secciones.

- Inclusión de contenido único en categorías para reducir la tasa de similaridad y ampliar la cantidad de keywords semánticamente relacionadas en los contenidos.

La forma de usarlo no es trivial, pero sería más o menos la siguiente:

1º Instalas el plugin

2º Entras en el plugin que está en Ajustes > Category Meta y creas un campo personalizado: En este caso hemos creado el campo interlinking para añadir los siguientes niveles de enlazado acorde a la arquitectura que hemos definido.

3º Una vez que tienes ese campo creado, en esa tipología de página aparecerá ese campo para poder rellenarlo:

4º Por último en el código donde quieras hacer uso de este campo lo deberás llamar con una llamada de este tipo:

$categoria = get_query_var(‘cat’) ;

if (function_exists(‘get_terms_meta’)) {

$interlinking = get_terms_meta($categoria, ‘interlinking’, true);

}

echo ‘<div>’.$interlinking.'</div>’;

Con este método es como hemos implementado la arquitectura de enlazado interno que tendrá la siguiente forma:

Los enlaces están contenidos en las cajas grises, que en la versión móvil será lo primero que vea el usuario junto con el H1 y H2 por lo que buscamos una mejora en la tasa de click y en la navegabilidad entre secciones.

¿Estado del proyecto en la tercera semana?

Como podéis ver tuvo una pequeña mejoría a principios de semana pero ahora está en los valores estables en los que parece haber quedado tras las primeras acciones de optimización. De momento no tenemos mejora, pero no sigue en caída libre como cuando lo cogimos, así que paso a paso.

Planificación de acciones futuras

El listado de tareas que hemos marcado en este sprint son las siguientes:

– Auditoria

– Análisis del problema de indexación– Keyword research y elaboración de titles+metas

– Auditoría de links y desindexación de enlaces

– Eliminación de las SERPs de URLs desindexadas– Elección del nuevo Theme

– Elaboración de plan de acciones de blackhat con redes sociales

– Inyección de tráfico cualificado (tras optimización y migrado al nuevo servidor y con el nuevo theme)

– Análisis de CTRs + Mejoras de titles y metas (Tras cargar los titles y un tiempo de revisión)– Preparación del servidor y nuevo entorno– Preparar la migración del entorno con los redirects

Estos deben ser los siguientes pasos a hacer con el proyecto. Y en los próximos 7 días queremos abarcar:

– Migración de la web al nuevo entorno, con las consiguientes redirecciones del subdominio al dominios principal y monitorización de urls con más tráfico.

– Auditoría de links y desindexación de enlaces en el dominio final

– Inyección de tráfico cualificado

– Análisis del problema de indexación

– Optimización final del rendimiento en el nuevo servidor

SEMANA 4:

Otra semana más y estamos de vuelta con el reto iSocialWeb. Esta semana se han producido cambios relevantes en el proyecto así qué… AL TURRÓN!

¿Qué acciones hemos hecho?

Estas son las tareas que teníamos para esta semana:

– Migración de la web al nuevo entorno, con las consiguientes redirecciones del subdominio al dominios principal y monitorización de urls con más tráfico. ✅

– Auditoría de links y desindexación de enlaces en el dominio final ✅

– Inyección de tráfico cualificado ✅

– Análisis del problema de indexación ✅

– Optimización final del rendimiento en el nuevo servidor ✅

¡Por fin una semana que hemos podido acabar todo!

Auditoría de Links:

El trabajo de linkbuilding que tenía el proyecto, era relativamente natural, porque lleva muchísimos muchísimos años en internet (más de 15 años). El problema está en que tenía ataques de SEO negativo y bastante mierda acumulada.

Aquí teníamos que tener en cuenta que contábamos de base con un subdominio e íbamos a pasar todo al dominio principal, así que hemos hecho el análisis sobre el subdominio y sobre el dominio principal.

Para limpiar en una primera fase el perfil de enlaces, hemos seleccionado todos aquellos que vemos que no aportan un valor al proyecto y/o no son naturales. Para ello exportamos los links de ahrefs y GSC, los mergeamos datos, luego de forma manual hemos ido marcando los no deseados.

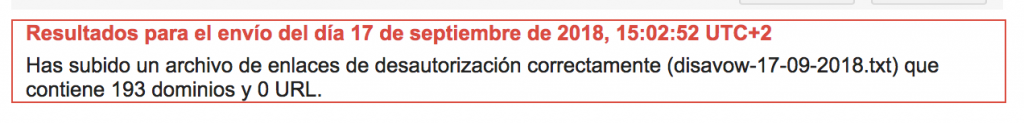

Todo esto lo hemos metido en un disavow.txt y se lo hemos enviado al amigo google aquí:

https://www.google.com/webmasters/tools/disavow-links

A día de hoy creo que esto es poco útil, pero como íbamos a cambiar de subdominio a dominio, empezar con este dominio «nuevo» y queremos tener todo lo más limpio posible pues parece que así dormimos mejor por las noches 😉

Inyección de tráfico cualificado:

Una vez hecha la migración al nuevo entorno y este estaba más pulido a nivel de rendimiento, tocaba empezar a hacer acciones para ir recuperando la tendencia de forma más directa. Para ello y como contamos con proyectos que son afines a este nicho, hemos puesto unos banners en varios proyectos y estamos derivando algo de tráfico cualificado hacia la web.

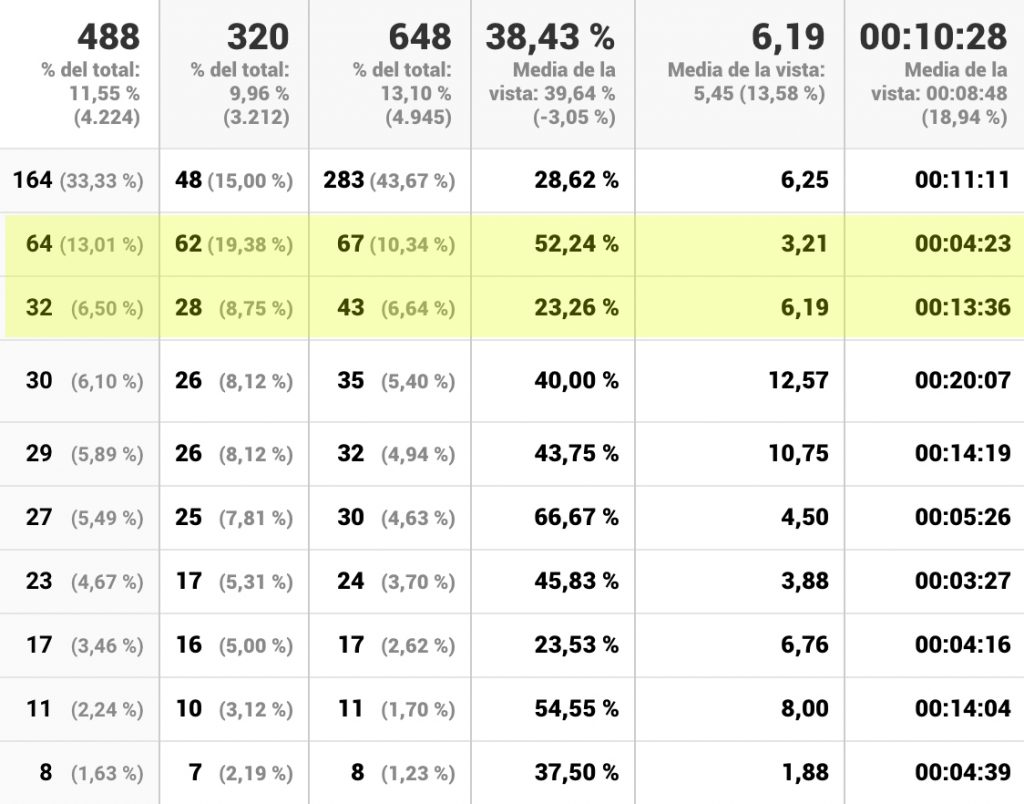

He de decir que esperaba que entrara más tráfico referido, pero de momento está entrando poquito, iremos haciendo pruebas cambiando el banner a ver si mejoramos el CTR de estos banners y podemos derivar de forma progresiva algo más de tráfico. Estos son los datos de ayer domingo del tráfico referido. Podéis ver que ahora mismo son la segunda y tercera fuente de entrada de tráfico referido y que uno de los medios nos aporta un tráfico de mayor calidad que el otro, veremos como evoluciona este punto y sobre eso iremos tomando decisiones:

Esta generación de banners también ha servido para meter los primeros links hacia la web. Es una web con bastante autoridad y no necesitará mucho trabajo de LB, pero como hemos modificado toda la arquitectura y estructura de urls, queremos hacer algún link directo a estas nuevas urls para mejorar la estrategia actual de enlazado que tiene el proyecto.

Arquitectura en el nuevo desarrollo:

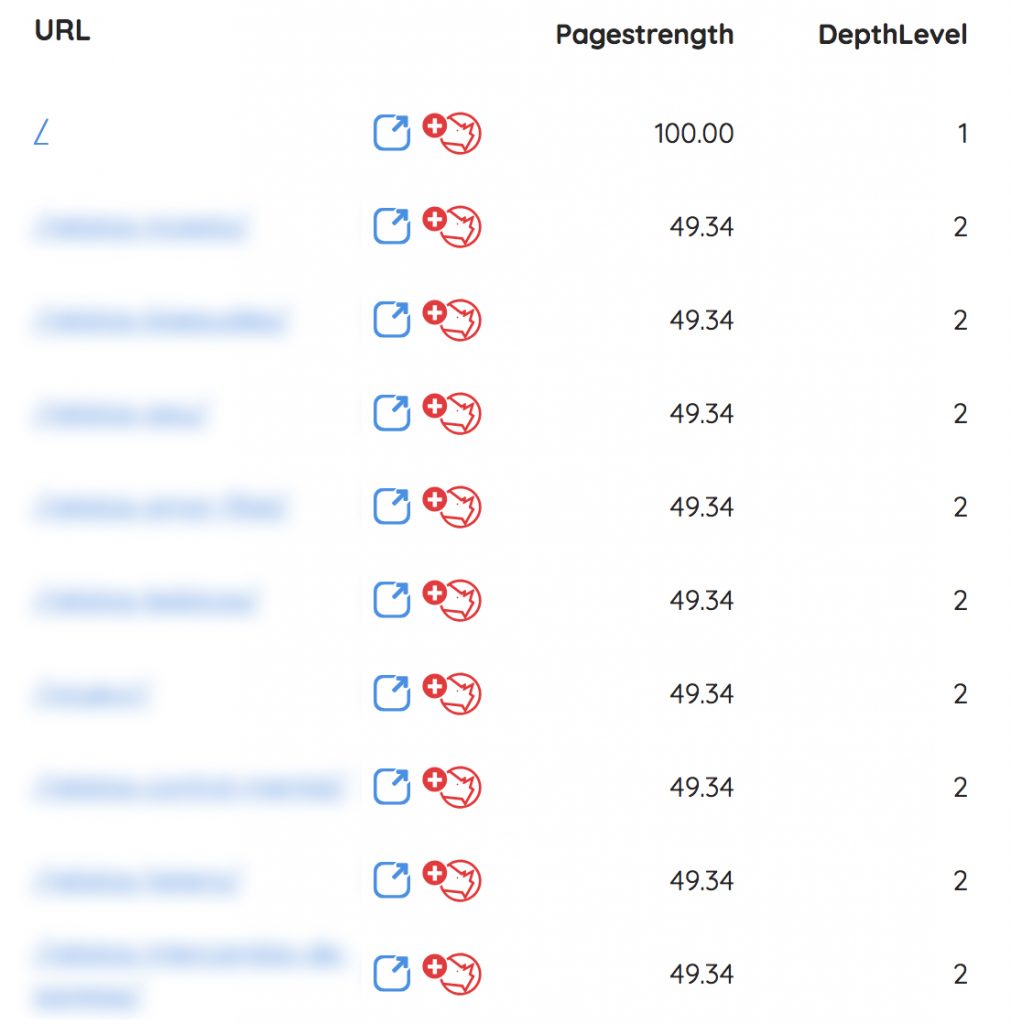

Ahora que ya tenemos la web en el entorno definitivo hemos pasado a acabar de revisar y reoptimizar la arquitectura para pasar el mayor número de linkjuice a las secciones que más nos interesa posicionar.

Para ello nos ayudamos de dos herramientas: Screaming Frog unida a la API de ahrefs y de la sección de arquitectura de Safecont. Después de esto hemos conseguido que todas las categorías principales estén a un segundo nivel de profundidad y que el reparto del Pagestrength (≈ PageRank), esté más optimizado, aunque todavía hay que seguir mejorándolo:

Generación de contenido único de calidad en las secciones principales para SEO

Ahora que ya está la web casi lista a nivel de OnPage, estamos ampliando y reoptimizando contenidos en las secciones que tienen más valor de SEO. Estas secciones son principalmente categorías y la home. Por ello nos estamos apoyando en nuestro redactor de iSocialWeb Ander (un abrazo crack) y estamos generando contenido único para cada categoría. La finalidad de esto es reducir al máximo la similaridad en estas páginas principales para SEO, atacar keywords relacionadas (en este texto) con la key principal de cada una de estas URLs e intentar resolver lo mejor posible la intención de búsqueda de estas landings.

¿Estado del proyecto en la cuarta semana?

Aquí hay que tener en cuenta que la web ha cambiado totalmente. Estructura, theme, dominio, diseño, UX… y esto necesitará de más tiempo para estabilizarse y empezar a dar resultados. De hecho actualmente la key principal del nicho no está ni en top 100 y las keys de las categoría prácticamente igual. Estamos a nivel de tráfico, viviendo de longtails y marca.

Además el estado de indexación de la web final todavía está en proceso…

**Lógicamente hemos creado y reenviado un sitemap nuevo desde GSC.

También apuntar que el dominio principal tenía ya tráfico de marca y referido, con alrededor de 900 visitas diarias aproximadamente. Esto sumado a las 3900 que tenía el subdominio del que partíamos debería estar entorno a las 4800 visitas diarias a la que estabilice si va todo bien.

Como vemos en la foto del estado actual, el tráfico todavía está en 4200 visitas diarias, por lo que le queda margen de mejora.

Planificación de acciones futuras

El listado de tareas que hemos marcado en este sprint son las siguientes:

– Auditoria– Análisis del problema de indexación– Keyword research y elaboración de titles+metas– Auditoría de links y desindexación de enlaces

– Eliminación de las SERPs de URLs desindexadas– Elección del nuevo Theme

– Elaboración de plan de acciones de blackhat con redes sociales– Inyección de tráfico cualificado (tras optimización y migrado al nuevo servidor y con el nuevo theme)

– Análisis de CTRs + Mejoras de titles y metas (Tras cargar los titles y un tiempo de revisión)– Preparación del servidor y nuevo entorno– Preparar la migración del entorno con los redirects

Estos deben ser los siguientes pasos a hacer con el proyecto. Y en los próximos 7 días queremos abarcar:

– Eliminación de las SERPs de URLs desindexadas

– Creación de la estrategia de Linkbuilding y generación de los primeros links

– Elaboración de plan de acciones de blackhat con redes sociales

– Seguir trabajando en la arquitectura

– Seguir revisando y reoptimizando contenidos

– Seguir redactando contenido nuevo para las categorías y subcategorías.

SEMANA 5:

Bueno bueno, hoy traemos novedades interesantes en el #RetoiSocialWeb. No perdamos un minuto más en verlas 😉

¿Qué acciones hemos hecho?

Estas son las tareas que teníamos para esta semana:

– Eliminación de las SERPs de URLs desindexadas (en proceso) ❌

– Creación de la estrategia de Linkbuilding y generación de los primeros links ✅

– Elaboración de plan de acciones de blackhat con redes sociales (hemos elegido el canal y la estrategia, ahora falta ponerlo en marcha) ✅

– Seguir trabajando en la arquitectura ❌ (vamos a ver primero cómo evoluciona y si necesitamos optimizar más)… Además queremos esperar a usar Link Optimizer de los amigos de Safecont 😀

– Seguir revisando y reoptimizando contenidos ✅

– Seguir redactando contenido nuevo para las categorías y subcategorías.(en proceso) ❌

Seguir revisando y reoptimizando contenidos

Este ha sido un punto vital esta semana. Ponemos en antecedentes… normalmente cuando hacemos un análisis de contenidos en proyectos de muchas URLs lo hacemos sobre una muestra representativa del total de las URLs, a no ser que el proyecto tenga un capital importante que se pueda destinar a este fin. En este caso al ser un proyecto propio donde queremos invertir el mínimo posible, habíamos cogido una muestra de 5000 URLs para no consumir más créditos de Safecont. Cuando analizamos en una primera fase los contenidos sacamos varios patrones de urls que estaban generando thin content y derivado o en añadido similaridad, y estos fueron los primeros que limpiamos. Ahora con una segunda revisión más en detalle sobre esta muestra, empezamos a ver patrones de este tipo:

nombre-del-articulo

nombre-del-articulo-3

nombre-del-articulo-643

nombre-de-artículo

Detectamos que había varios artículos que variaban poco su contenido o nada y que únicamente cambiaban unos caracteres en la url, pero el contenido de estas URLs tenían una tasa de similarididad de entre el 97 y el 100%. Vamos que había mierda escondida debajo de la alfombra por un tubo.

¿Qué acciones hemos hecho para solventar este problema?

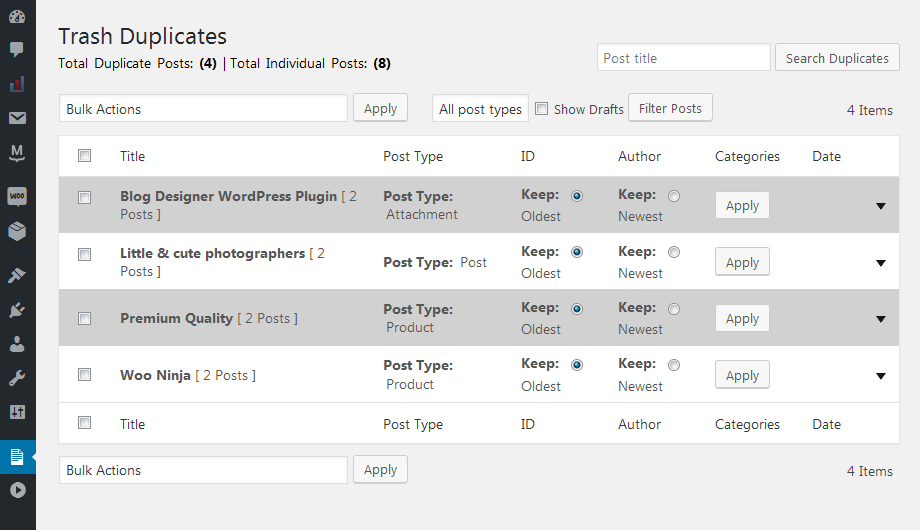

Como parece un patrón bastante claro, de momento, lo que hemos hecho es coger un plugin de detección de duplicados para wordpress que se llama «Trash Duplicates And 301 Redirection Pro» que tiene un coste de 15$ y nos cubría muy bien las necesidades específicas de este proyecto (ojo que es un mojón de plugin, pero hacía justo lo que necesitábamos)

¿Por qué este plugin?

Tras analizar el problema, teníamos que decidir cual sería la solución más práctica.

OJO CUIDAO: La solución más práctica no es siempre la mejor.

Hay que tener en cuenta muchos factores cuando estás trabajando el SEO de un proyecto. Evidentemente la mejor solución es coger uno por uno cada caso y analizar la repercusión del mismo y en función de eso unificar, mejorar contenidos, redireccionar… en función de la casuística. En este caso el problema es que hay mucho contenido duplicado que no aporta valor y cumple un patrón específico.

Para atacarlo, hemos exportado el listado de todos los posts que cumplen esta casuística, después de esto hemos cruzado los datos con el tráfico que reciben estas urls. Ir al detalle para un volumen como este de tráfico, no tiene sentido a ojos de coste de oportunidad, es por esto que hemos decidido borrar y redireccionar al post que tiene más antigüedad del grupo de duplicados. Esto precisaba hacerse de una forma automática para perder el menor tiempo posible. Y la solución es este plugin 😉

Ya en faena… después de pasar el plugin hemos detectado que hay más de 2000 artículos con contenido duplicado. Así que hemos procedido a eliminar dichos contenidos y aplicar las redirecciones correspondientes.

Aquí hay un punto importante a tener en cuenta que nos lo hemos encontrado en muchos proyectos en la agencia que vienen heredados. Cuando se hace una limpieza de contenidos, no vale con hacer un redirect del contenido a eliminar al nuevo, para muchos será una obviedad pero…, además hay que eliminar el contenido redireccionado…

¿Por qué?

Pues porque esa url tendrán links internos apuntando hacia él, dentro de la propia web que generarán redirecciones 301 y por el mero hecho de borrarlo ya limpiarás automáticamente, por ejemplo, los links en los listados. También si no se elimina estará en el sitemap… vamos que generará acciones tanto de los usuarios como de googlebot innecesarias y que pueden causar frustración o confusión al usuario.

Creación de una estrategia de LB

Necesitaríamos varios posts para explicar cómo hacemos una estrategia de LB para un proyecto, pero vamos a intentar esquematizarlo en un checklist sencillo los puntos principales. Por cierto, si queréis saberlo de primera mano, os podéis apuntar al master SEO de Webpositer donde doy una clase de esto específicamente 😉 (un abrazo Luis y Compañía).

- Analizamos la estrategia de la media del nicho. Vemos qué es lo normal en este nicho en referencia a: tipología de enlaces, anchors, tipología de urls más enlazadas, webs de referencia…

- Comparamos la media del nicho con el proyecto que vamos a trabajar.

- Revisamos de forma individual cada uno de los factores del enlazado.

- Vemos las necesidades del proyecto y trazamos la estrategia.

En este caso es un proyecto que tiene muchísimo LB ya hecho por su antigüedad, así que únicamente buscaremos ir generando una estrategia de enlazado más compensada en las secciones principales de la web, para distribuir de una forma más productiva el valor de los enlaces. Además vamos a intentar normalizar los anchors de algunas categorías que están atacadas de una forma más agresiva haciendo uso de más enlaces de marca y url.

¿Estado del proyecto en la quinta semana?

Primero de todo vamos a ver temas de carga e indexación sobre datos reales en GSC:

Vemos que ese problema de indexación que teníamos ya está desapareciendo (hay que ver la evolución) y que también la mejora en el rendimiento del sistema que habíamos implementado con la ayuda de Brutalsys ya se ve reflejada, habiendo bajado el tiempo de descarga a la mitad.

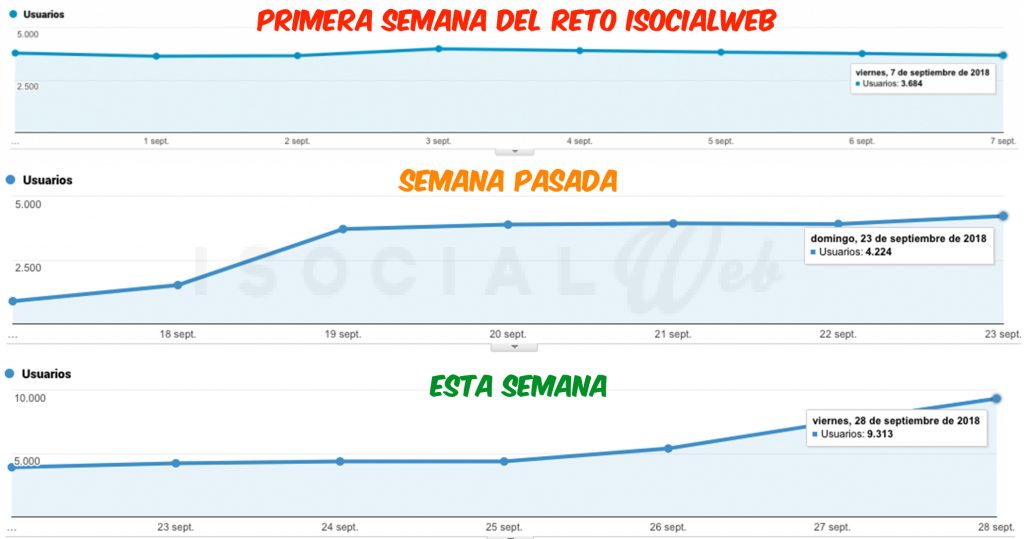

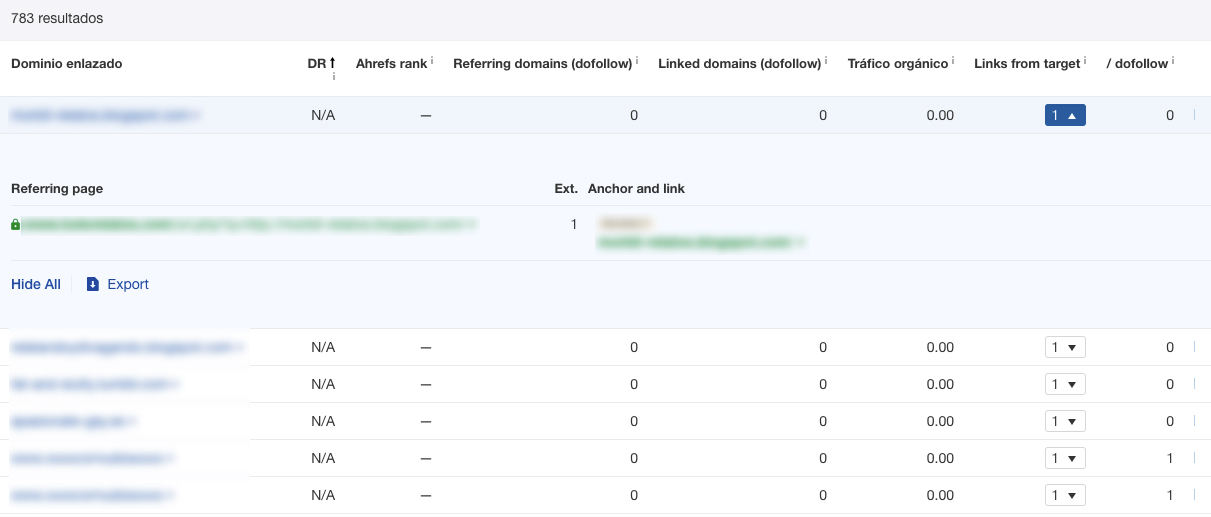

Y ahora el tráfico que sé que es lo que estáis esperando….

Como se puede ver en la imagen la primera semana el proyecto estaba en caída libre en 3700 visitas y bajando, después de algo más de un mes de trabajo estamos en 9300 y subiendo, por lo que parece que estamos empezando a tener un cambio de tendencia interesante.

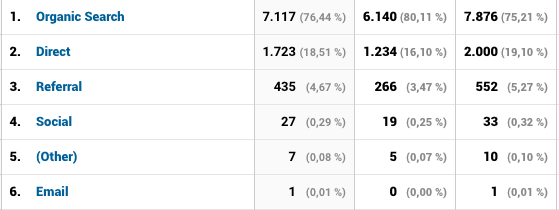

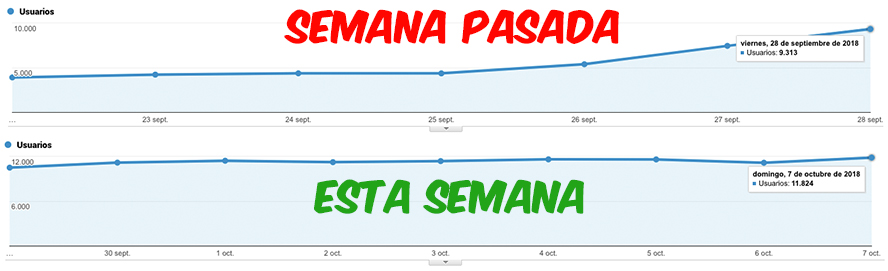

Aquí dejamos también el tráfico desglosado por canales:

Y ¿Qué pasa con la monetización?

Muchos os estaréis preguntando cuando dinero está dando el proyecto. La respuesta es CERO. Entonces… ¿Estáis haciendo esto por amor al arte? Pues más bien NO. La idea es en estos primeros momentos de recuperación, afectar al mínimo la experiencia de usuario. A la que veamos que el proyecto empiece a estar en valores que consideremos buenos de tráfico y asentado empezaremos a meter monetización y a recuperar la inversión 😉

Planificación de acciones futuras

Estos deben ser los siguientes pasos a hacer con el proyecto. Y en los próximos 7 días queremos abarcar:

– Eliminación de las SERPs de URLs desindexadas

– Seguir con la estrategia de LB

– Implementación del plan de acciones de blackhat con redes sociales

– Seguir redactando contenido nuevo para las categorías y subcategorías

SEMANA 6:

Otra semana más con el #RetoiSocialWeb y parece que al señor google le está gustando el trabajo que estamos haciendo 😀

¿Qué acciones hemos hecho?

Estas son las tareas que teníamos para esta semana:

– Eliminación de las SERPs de URLs desindexadas ✅

– Seguir con la estrategia de LB ✅

– Implementación del plan de acciones de blackhat con redes sociales (en proceso) ❌

– Seguir redactando contenido nuevo para las categorías y subcategorías ✅

Estrategia de LB

Como ya introdujimos en la semana anterior, en una primera fase hemos analizado cual es la media del nicho, viendo qué tipología de enlaces eran los más acertados y necesarios para este proyecto en función de:

- La media: Lo que más se usa en este sector

- La tipología de enlaces actuales vs la media

- Las necesidades actuales del proyecto por url y general.

Una vez analizado esto hemos empezado con la búsqueda de enlaces de autoridad para el proyecto. En esta primera fase estamos haciendo una batida de todos los enlaces que tienen autoridad, pueden derivar tráfico y están posicionados para las keywords que queremos atacar. Con esto buscamos links que puedan atraer tráfico cualificado que generen una buena UX dentro del proyecto, que sean de entidades fiables y que además doten a este de una mayor autoridad.

Todos y cada uno de los enlaces que publicamos los monitorizamos y vemos la repercusión sobre el objetivo. Sobre esto vamos moldeando las acciones que mayor impacto van teniendo.

Captación de enlaces en la competencia

En iSocialWeb siempre solemos decir que el mejor enlace es el que viene, sin quererlo, de tu peor enemigo. A qué nos referimos con esto, pues a que si consigues enlaces desde las webs que están compitiendo contigo en las SERPs denotarás a google que eres una fuente interesante para esos resultados y te ranckeará mejor.

¿Cómo hemos conseguido enlaces desde la competencia?

Ojo, que aquí no estamos hablando de ver los enlaces de la competencia sino de conseguir enlaces desde la competencia. Existen multitud de vulnerabilidades en los diferentes CMS y en programación en general mediante los cuales puedes incluir un enlace. No estoy hablando de hackear una web ni nada ilegal, me refiero a estudiar el entorno y aprovechar el conocimiento en nuestro favor.

Algo tan sencillo como incluir una etiqueta que no existe como rel=»dofollow» en un enlace, cambiar la forma de escribir un html o detalles así pueden hacer en frente a una entrada de datos puedas obtener un enlace positivo para tu proyecto.

Ahora os vamos a contar una forma mediante la cual nosotros detectamos enlaces en la competencia muy fácilmente y luego vemos la forma de explotarlos.

Paso 1: Detección de enlaces salientes

Si hablamos de enlaces hablamos de Ahrefs, no existe ninguna herramienta a día de hoy en el mercado que se le acerque ni un poco en este área del SEO. Así que vamos a aprovecharnos de todo su potencial.

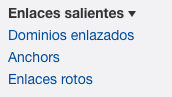

Primero vamos a coger una web de la competencia, una vez seleccionada introduciremos este dominio lo introduciremos en ahrefs. A continuación nos iremos en la sección del lateral izquierdo a Enlaces salientes > Dominios enlazados.

En este punto obtendremos un listado de todos los dominios a los que está enlazando el proyecto.

Paso 2: Filtrado de enlaces relevantes

Aquí lo que nos interesa no son los dominios con más autoridad, ya que estos serán sus redes sociales o enlaces que ha puesto de forma intencionada el dueño del proyecto, nos interesa toda la purria que se ha podido colar en forma de enlace dofollow o redirección, dependiendo de lo que necesitemos. Para ello ordenaremos en forma descendente por DR eligiendo los dominios de menor autoridad. Y obtendremos una lista de este tipo:

Paso 3: Sacar patrones y vulnerabilidades

Ahora ya sabemos que de alguna forma existen enlaces salientes de baja calidad saliendo desde el proyecto. Es evidente, que nadie quiere enlazar a webs de mierda en sus proyectos, así que si esto sale es porque hay una oportunidad.

Ahora lo que necesitamos es desplegar en la opción «Link from target» una a una las diferentes páginas y buscar un patrón en ellas o desde qué parte de la web se está pudiendo sacar un enlaces 😉

¿Estado del proyecto en la sexta semana?

Bueno ahora sin más dilación vamos a ver los números que hemos tenido esta semana:

Y esta es la distribución del tráfico de ayer Domingo:

Como podéis ver esta semana hemos subido una media de 2500 visitas diarias y ya se empieza a estabilizar el tráfico en los valores actuales. Ahora empezaremos con la guerra más lenta seguramente de ir asentando este tráfico y atacando las keys principales para ir subiendo de forma gradual el mismo. Esto dependerá de que se acabe de asentar el proyecto y ir viendo CTRs, canibalizaciones, respuesta frente a las acciones de Linkbuilding…

Planificación de acciones futuras

Estos deben ser los siguientes pasos a hacer con el proyecto. Y en los próximos 7 días queremos abarcar:

– Seguir con la estrategia de LB

– Seguir con la implementación del plan de acciones de blackhat con redes sociales

– Revisión de la evolución del proyecto y decisión de acciones necesarias en función del mismo.

SEMANA 7:

Una semana más en el #RetoiSocialWeb y aquí seguimos creciendo semana a semana 😀

¿Qué acciones hemos hecho?

Estas son las tareas que teníamos para esta semana:

– Seguir con la estrategia de LB ✅

– Seguir con la implementación del plan de acciones de blackhat con redes sociales (en proceso) ❌

– Revisión de la evolución del proyecto y decisión de acciones necesarias en función del mismo. Canibalizaciones ✅

Detección y corrección de canibalizaciones

¿Qué es una canibalización?

Esto es algo muy básico en SEO, pero como este post lo está leyendo gente de todos los niveles, lo explicaremos. Una canibalización se produce cuando para una misma palabra clave, google no sabe qué URL posicionar porque recibe señales equívocas o poco clarar de cual es la URL que cumple mejor la intención de búsqueda del usuario. Esto si no se soluciona origina que estés dividiendo fuerza entre varias URLs para conseguir posicionarte para esa palabra.

¿Cuando se produce una canibalización?

Cuando un proyecto gira entorno a una terminología muy concreta, por muy bien que hagas el análisis e implementación del keyword landing siempre aparecen casos de canibalizaciones. Os voy a poner un ejemplo donde se ve muy claro.

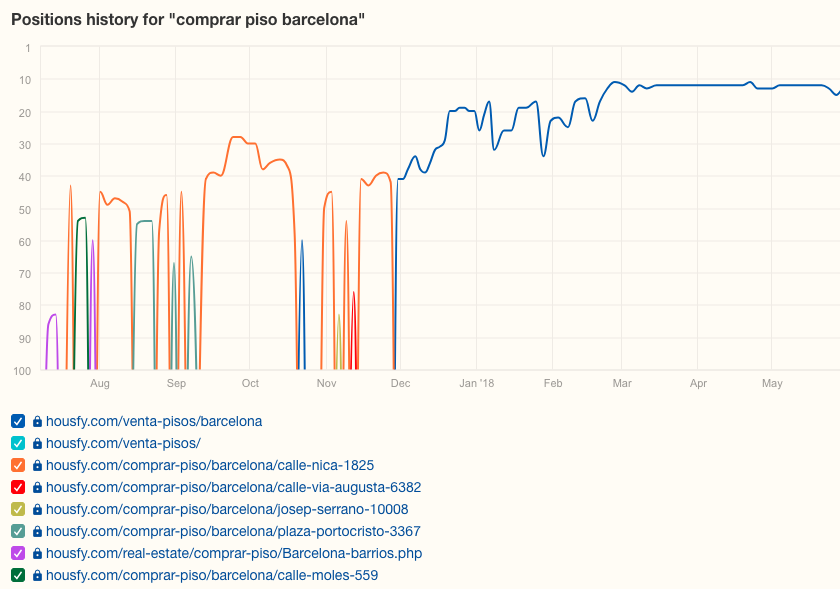

Imaginaros que tenéis un portal de anuncios, cojamos por ejemplo uno inmobiliaria, como puede ser el caso de éxito SEO Housfy. Si tú haces los titles para una sección de ejemplo, que podría ser:

Comprar piso en Sabadell, Barcelona | Housfy

Aquí tenemos dos posibilidades de canibalización claras, por un lado una keyword genérica como puede ser «comprar piso» y además tenemos la otra posible canibalización que puede ser «comprar piso Barcelona«.

¿Por qué se pueden dar estas canibalizaciones?

Imaginaros el hipotético caso de que por estrategia de negocio nos interesa en Barcelona, cuando sale el proyecto, empezar a posicionar la ubicación de Sabadell. Se trabajaría esta, porque el proyecto nada más nacer no tiene tanta fuerza a nivel de SEO para competir de igual a igual en Barcelona capital.

Si un usuario ubicado en Sabadell que pertenece a Barcelona hace búsquedas de «comprar piso» y acaba llegando al proyecto. Se establece una relación entre esa intención de búsqueda y la landing a la que acaba llegando. Esto además se puede ver también afectado por la campaña de SEM que derive tráfico ahí y por el enlazado interno. Donde en un principio al tener un mayor número de anuncios en esta ubicación, tendrá un mayor enlazado y derivaría más tráfico hacia esta ubicación. Por ende se posicionará mejor y acabará pasando algo como esto…

En esta gráfica podéis ver cómo para la búsqueda «comprar piso barcelona» se han ido posicionando todas y cada una de las urls que se ven en la captura. Esto es algo normal, que corresponde a la evolución de un proyecto grande.

¿Cómo detectarlo?

Mucha gente no lo sabrá o no habrá caído en esta funcionalidad de Ahrefs. Ahrefs tiene una opción de trackeo de keywords y añade en este trackeo un histórico de URLs. Gracias a este histórico podemos revisar para las diferentes palabras clave cuales son las URLs que se han posicionado. Si encontramos más de una URL, es que tenemos un caso de canibalización.

A esta opción llegamos desde: Búsqueda orgánica > Palabras clave orgánicas > Icono siguiente:

¿Cómo solventarlas?

Hay algunas canibalizaciones que se acaban solventando con el propio funcionamiento del proyecto haciendo las cosas bien. Hay otras que se generan a partir del funcionamiento de este. Pero hay diferentes formas de solventarlas o evitarlas.

- Un buen keyword landing. Intentar que cada keyword e intención de búsqueda esté atacada en una única URL.

- Buena arquitectura. Optimizando el anchoring del enlazado interno hacia las secciones correspondientes.

- Derivando el tráfico o dirigiendo a los usuarios hacia donde cumplen su intención de búsqueda. Por ejemplo, si en el caso anterior el usuario llega con la búsqueda de «comprar piso» a un piso determinado. Pues le ayudaremos con un camino de migas o cualquier método de enlazado que le resulte útil hacia la sección que mejor cumple su intención de búsqueda.

- Con un correcto uso de heading y titles. Evidentemente si hacemos uso de las mismas keywords en titles o headings de diferentes urls, fomentaremos las canibalizaciones.

¿Estado del proyecto en la septima semana?

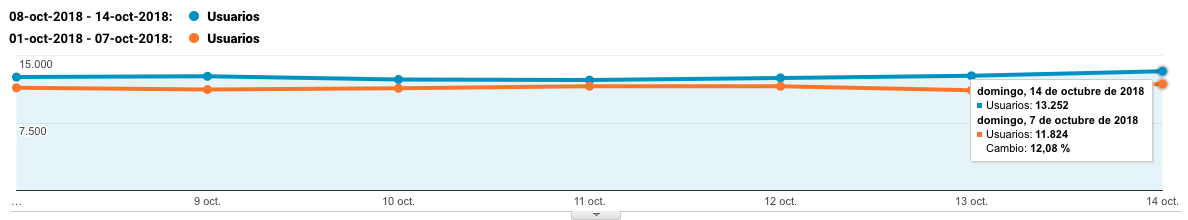

Y aquí tenemos la evolución del proyecto en tráfico con respecto a la semana pasada:

Como se puede ver en la captura esta semana con respecto a la semana pasada ha habido un crecimiento del 12% y hemos pasado de 11.824 visitas el domingo de la semana pasada a 13.552 vistas ayer 😉 Así que seguimos creciendo!

Planificación de acciones futuras

Siguientes pasos para los próximos 7 días:

– Seguir con la estrategia de LB

– Seguir con la implementación del plan de acciones de blackhat con redes sociales

– Revisión de la evolución del proyecto y decisión de acciones necesarias en función del mismo.

SEMANA 8: CONCURSO SEO + 15.000€ en premios

CATACRAKEN!!! En esta semana os traemos un sorpresón de los gordos. Gracias a la gran aceptación que está teniendo el #retoiSocialWeb y a la comunidad de SEO Hispana que es la HOSTIA, vamos a montar el que puede llamarse EL CONCURSO SEO, con mayúsculas.

Y es que este reto no podría hacerse posible sin el trabajo y el aprendizaje obtenido por todo el equipo de iSocialWeb, gracias a muchos otros grandes profesionales, que han compartido y comparten, su conocimiento y su experiencia a través de cursos, formaciones o con el desarrollo de herramientas. Es por esto que hemos querido hacer un reconocimiento público a todo ese gran trabajo y les hemos pedido colaboración en esta iniciativa. Y la respuesta ha sido para FLIPAR!

Primero os contaremos el concurso. Desde hoy y hasta el día 1 de Diciembre NO vamos a compartir más la evolución del reto, pero en lugar de ello vamos a hacer un CONCURSO de predicción de su evolución. Para ello haremos una publicación en twitter para acceder a una URL donde podréis indicar el tráfico que tendrá la web al final del reto que acabará a fecha 1 de Diciembre. Con esa votación y vuestros datos, haremos un sorteo de 3 MEGA LOTES compuestos por herramientas, recursos y formación para que como nosotros aprendáis y disfrutéis de lo mejor del SEO en Español.

En breve anunciaremos los premios, pero hoy os vamos a dar un adelanto de la lista de todos los cracks que van a participar en este CONCURSAZO!

BONUS

Además habrá varios descuentos para TODOS los participantes

Estos PREMIOS se repartirán entre 3 GANADORES/AS tras los resultados del 1 de Diciembre.

Además es importante recalcar que los 3 premios serán regalos 100% Gratuitos. Nuestra idea es que las 3 personas afortunadas puedan disfrutar de los premios independientemente de su poder adquisitivo, sin descuentos ni promociones. Y todo esto gracias a la ayuda de todo este grupo de excelente profesionales y personas. ¡Desde iSocialWeb, mil gracias a todos!

Esta semana empezaremos el concurso en el que se podrá participar sólo durante 1 semana, así que estar atent@s!

P.D: Si alguna empresa del panorama del SEO Hispano quiere añadirse al concurso con premios, que no dude en contactarnos 😉

Alvaro Peña de Luna

Co-CEO y Head of SEO de iSocialWeb, una agencia especializada en SEO, SEM y CRO que gestiona más de +350M de visitas orgánicas al año y con una infraestructura 100% descentralizada.

Además de la empresa Virality Media, una empresa de proyectos propios con más de 150 Millones de visitas activas mensuales repartidos entre diferentes sectores e industrias.

Ingeniero de Sistemas de formación y SEO de vocación. Aprendiz incansable, fan de la IA y soñador de prompts.