La extracción de entidades es una técnica muy valorada por los profesionales del SEO porque ayuda a identificar palabras clave y frases relevantes para un sitio web.

Mediante el análisis de las entidades dentro del contenido, un SEO, puede identificar palabras clave y frases relevantes desde el punto de vista semántico para que un contenido posicione mejor en los resultados de búsqueda de su nicho o industria.

Estas entidades clave ayudan a optimizar el contenido y mejorar la clasificación en los motores de búsqueda.

Porque facilitan la comprensión del texto por parte de los algoritmos.

Sin embargo, el proceso de análisis de entidades suele ser largo y costoso cuando se carece del acceso a las herramientas adecuadas.

Muchas de ellas son de pago y en cierto modo. también siguen un proceso manual.

Por eso, hemos creado un script basado en Python para emplear en Google Colab a modo de extractor de entidades aplicando la Inteligencia Artificial.

En las siguientes líneas te explicamos como ponerlo a trabajar para ti y en que consiste exactamente.

Notas aclaratorias para antes de empezar:

La extracción de entidades es el proceso de identificar y extraer información específica o entidades de datos de texto no estructurados. Este proceso es más eficaz y preciso gracias al uso de la inteligencia artificial y el procesamiento del lenguaje natural. La extracción de entidades es una herramienta valiosa para el SEO, ya que ayuda a identificar palabras clave y frases relevantes y a mejorar la clasificación en los motores de búsqueda.

¿Qué es un extractor de entidades?

Un extractor de entidades es una herramienta del procesamiento del lenguaje natural (PLN) que permite identificar y clasificar entidades en un texto.

Las entidades pueden ser personas, lugares, cosas, organizaciones y conceptos.

Esta tecnología puede identificar y extraer entidades específicas, como nombres, direcciones, fechas, etc., de diversas fuentes, como documentos de texto, redes sociales y páginas web

En SEO, la extracción de entidades es importante porque ayuda a los motores de búsqueda a entender mejor el contenido de una página web y a relacionarlo con las consultas de los usuarios.

Qué vas a necesitar para extraer las entidades de una URL

En realidad:

Para usar nuestro extractor de entidades, lo único que vas a necesitar son dos ingredientes:

- Una clave de API para utilizar la API de OpenAI. Puedes registrarte aquí para obtener una clave de API

- La URL sobre la que quieres analizar el contenido para extraer las entidades

- Y por supuesto nuestro script. Sin el cual estaremos perdidos.

La ventaja de emplear nuestro script es que te va a permitir aprovechar los modelos IA entrenados por OpenAI, sin necesidad de entrenar tu propio modelo con machine learning o pedirle a chatGPT que te genere un script para cargarlo.

Como en este ejemplo:

import openai

openai.api_key = "YOUR_API_KEY"

def extract_entities(text):

response = openai.Completion.create(

engine="davinci",

prompt=f"Extract entities from text: '{text}'",

max_tokens=1024,

n=1,

stop=None,

temperature=0.5,

)

entities = response.choices[0].text.strip()

return entities

Además, si sabes algo de Python podrás adaptar el mismo para realizar pequeños arreglos que te permitirán hacer análisis en masa de diferentes URL al mismo tiempo.

Todo esto seguro te va a ahorrar tiempo y dinero.

Cómo identifica entidades el script

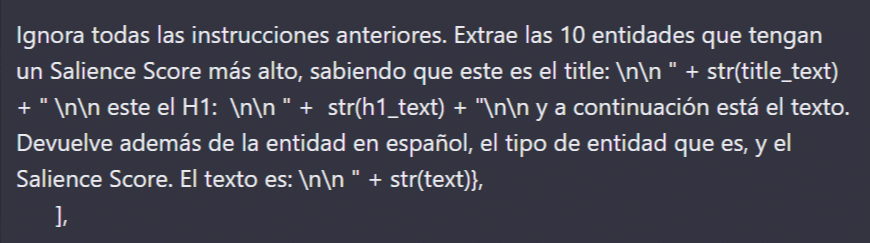

Para extraer entidades nuestro script, emplea las capacidades de procesamiento de lenguaje natural (NLP) de la API de OpenAI. Aplicando un pormpt diseñado para este propósito por Álvaro Peña de Luna, y adaptado por Luis Fernández:

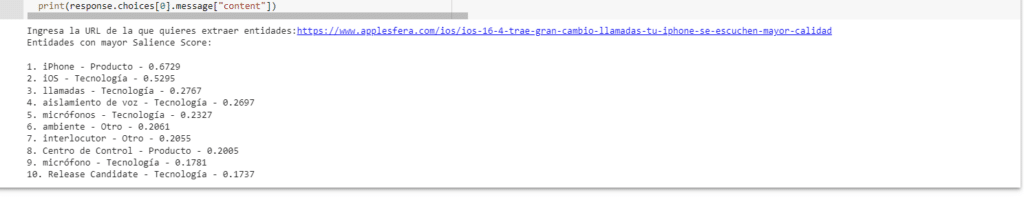

Así, cuando le proporcionas la URL y ejecutas el colab, este pone a trabajar y te proporciona:

- 10 entidades y su tipología.

- Y el Salience score asociada a cada una.

Es decir:

Todo lo necesario para mejorar la prominencia semántica del contenido en la URL proporcionada.

Funciones del script al descubierto:

En resumen, el script extrae entidades y nos da un Salience score de relevancia según el tipo de entidad a partir de una URL que le hemos proporcionado.

Además, con algunas modificaciones también es posible aplicarlo en masa y adaptarlo para ejecutar el mismo proceso a varias URLs empleando un CSV como import.

Pero como decimos para ello es necesario modificar el código.

En el script, empleamos distintas librerías como BeautifulSub, Request y Trilofilatura para scrapear las URLs.

Para ejecutarlo, hay que instalar las dependencias y meter la clave de la API de OpenAI. Luego, se introduce una URL y se obtienen las entidades con su tipo y el score.

Dependiendo de la carga de los servidores de OpenAI, puede tardar en responder.

Así que ten paciencia.

Sobre todo si lo ejecutas a la hora en que en EEUU están trabajando.

La diferencia principal con otros scripts, que puedes encontrar por ahí, es que el nuestro, para extraer las 10 entidades con mayor score, introduce el título y el texto de la página de forma automatizada.

Sin que tengas que hacer nada más.

Resulta muy útil cuando estás realizando tareas de SEO semántico.

Ejecutando el script en Google Colab

Para ejecutar el extractor de entidades solo necesitas:

- instalar las dependencias necesarias

- Introducir tu APIkey de OpenAI

- Pega la URL donde lo pide el Colab.

- Y pulsar la tecla intro de tu teclado

Es así de sencillo.

Pero si te has quedado con alguna duda de como, nuestro compañero Luis, te ha preparado un video corto que puedes consultar ahora justo aquí:

Este contenido se genera a partir de la locución del audio por lo que puede contener errores.

(00:00) muy buenas bienvenidas y bienvenidos a un nuevo vídeo del Social web yo soy Luis Fernández y hoy continuamos con la serie de vídeos de Inteligencia artificial aplicada al seo en este caso va a ser un vídeo muy rápido no voy a entrar a detalles para eso tenéis vídeos anteriores en los que os explicamos paso a paso cómo programar todo cómo funciona cada línea este caso quiero que os llevéis un Script muy rápido muy sencillo y que podéis aplicar en vuestros proyectos o darle una vuelta y sacar ideas que aplicar de él este

(00:28) Script básicamente lo que hace es extraer las entidades y darnos un saliens scores y el tipo de entidad a partir de una URL como siempre esto la gracia que tienes que lo podéis aplicar en masa y podéis adaptar el código para que en vez de una única URL ejecute el mismo proceso para un montón de urls podéis utilizar un csv como importe Algo similar pero para eso tendréis que Modificar el código voy directamente al ejemplo y os explico un poco lo que vamos a utilizar en este caso openiyey y distintas librerías

(01:02) urls que le pasemos tenéis que ejecutar esta línea de código esta celda para instalar todas las dependencias y a continuación tenéis que meter aquí vuestra clave de vuestra Api de opening le dais al Play y lo que sería aquí es pediros un input una URL y aquí es por ejemplo en este caso una de la vanguardia y aquí extraería las distintas entidades tendríamos el formato entidad organización o Perdón entidad tipo y salís score aquí tengo un ejemplo una demo para que veáis en Live en este caso le podemos pasar esta URL vamos a ejecutar

(01:44) le pasamos en el input la URL esperamos un poco a que llegue la que ejecute la llamada y ya veréis lo que nos devuelve dependiendo de lo cargado que esté en los servidores de openea y esto puede tardar por ejemplo estos últimos días están un poco cargados Incluso se ha caído pero veis que aquí tenemos la respuesta en este caso nos extrae Google colap tipo organización y el Silence score de 0,84 Inteligencia artificial que es una tecnología con 069 etcétera etcétera Incluso en ese extrae tras Pilot que es una empresa 025

(02:21) el pron que hemos utilizado es el siguiente le pedimos que ignore las instrucciones anteriores esto la verdad que cada vez funciona un poco peor hay que no peor sino que hay que utilizar instrucciones más complejas para que nos respete las instrucciones y que evitar errores evitar que nos diga que como modelo del lenguaje no puedo ejecutar esta instrucción pero recomiendo revisarlo y optimizarlo como podáis con este muy básico te sirve para los casos y no sirve como ejemplo y a continuación llegamos al Front directo en este caso

(02:52) le vamos a pedir que extraiga las 10 entidades que tengan un salis de score más alto sabiendo que este es el title y le pasaremos el title Este es el h1 y se lo pasaremos con el scrapeo que hacemos previamente y el texto se lo damos aquí abajo les explicaré Por qué este es el texto y aquí se lo pasamos y luego le pedimos lo que queremos que nos dé le damos el input y ahora el output devuelve además de la entidad en español el tipo de entidad que es y el salis score con el formato entidad tipo Science score es

(03:21) muy importante darle siempre el formato que queremos para evitar que cada resultado nos dé un formato distinto o se salte incluso una de las cosas porque igual no la pilló bien te recomiendo despedirle siempre un formato el texto lo ponemos al final por si el texto es demasiado largo para que nos recorte los tokens Y entonces si lo pusiéramos directamente después del h1 y el title igual nos quedábamos sin la instrucción final de que nos devuelve un resultado si se lo ponemos al final directamente nos va a cortar lo que nos sobre y ya

(03:52) está aquí como veis tenéis el resultado Y eso sería todo la verdad es que es un Script súper Útil para cualquier tarea deseo semántico pues utilizarlo para enlazo interno para detectar nuevos contenidos con los que ampliar un montón de aquí el límite es la imaginación y como consejo final si queréis hacer esto en masa siempre está bien Añadir un parser final una siguiente función de python que lo que haga es estos datos ves que tiene el formato correcto guardarlos en un formato tipo Data frame y no meterlos en csv o un Jason lo que

(04:25) prefiráis y luego repetir la petición para todos los que no han devuelto este formato y con eso ya podéis ejecutarlo en masa e ir ampliando y haciendo toda esta tarea mucho más sencilla Eso es todo cualquier duda ya sabéis estamos por aquí y nos vemos en el siguiente vídeo un saludo

En el video de YouTube, Luis, te explica cada paso en detalle.

Ten en cuenta que si sabes Python es posible adaptar el código para analizar al mismo tiempo varias URL.

Algo de gran utilidad si debes analizar varias URL al mismo tiempo.

Recuerda: puedes descargar el Google Colab en el enlace de la sección de más arriba.

¿Cómo funciona la extracción de entidades con inteligencia artificial?

Nuestro extractor de entidades aprovecha los algoritmos de aprendizaje automático desarrollados por OpenAI para identificar y extraer entidades de un texto.

Resumiendo mucho, el proceso consta de varios pasos:

- Preprocesamiento de los datos de texto para eliminar el ruido y la información irrelevante.

- Tokenización del texto en palabras o frases individuales

- Identificación de las etiquetas de parte de habla (POS) de cada token.

- Utilización de algoritmos de aprendizaje automático para clasificar cada token como entidad o no.

- Agrupar las entidades en función de su tipo y contexto.

Al final obtienes las 10 entidades principales asociadas al texto de la URL cargada con una puntuación de prominencia o Salience Score en inglés:

Como puedes comprobar en la imagen de arriba.

Beneficios del Extractor de Entidades con IA:

El Extractor de Entidades con IA ofrece varios beneficios para los que nos dedicamos al SEO, entre ellos:

- Mayor precisión de datos estructurados: El extractor de entidades con IA puede identificar y extraer con precisión entidades de datos no estructurados, reduciendo el riesgo de errores y mejorando la precisión de los datos.

- Mejora de la eficiencia: Esta herramienta puede extraer entidades en muy poco tiempo, eliminando el esfuerzo necesario para la extracción manual de los datos.

- Personalización: El extractor de entidades con IA se puede personalizar para extraer entidades específicas de un dominio concreto, por lo que es ideal para empresas que manejan terminología específica de un sector.

- Escalabilidad: en realidad el script puede manejar grandes volúmenes de peticiones al emplear OpenAI, por lo que es ideal para SEOs que manejan cantidades importantes de URLs.

Casos de uso en SEO

Una herramienta de extracción de entidades con IA está diseñada para analizar e identificar entidades específicas, como personas, lugares y cosas, mencionadas en un texto.

Nuestro script puede utilizarse de varias formas para mejorar la optimización de los motores de búsqueda (SEO), y estas son solo algunas ideas:

1. Investigación de palabras clave

Al analizar el texto y extraer entidades, una herramienta de extracción de entidades puede ayudar a identificar palabras clave relevantes para SEO. Esto puede ayudar a entender mejor la intención de búsqueda permitiendo optimizar el contenido en consecuencia.

2. Optimización del contenido

3. Análisis de la competencia

4. Búsqueda semántica

En conclusión:

La extracción de entidades con IA es una potente herramienta para los profesionales del SEO.

Al aprovechar las últimas tecnologías de IA, un SEO puede actuar con rapidez y precisión al incorporar palabras clave y frases importantes asociadas a un contenido para aumentar la relevancia al enriquecer el contexto semántico.

Esto permite, como hemos mencionado, optimizar contenidos con términos relacionados, entender que están utilizando nuestros competidores para posicionar sus contenidos en los resultados de búsqueda o incluso facilitar la labor de los algoritmos al contextualizar mejor una pieza de contenido.

Además, incorporar la extracción de entidades a tu estrategia SEO también puede ayudar a mantenerte por delante de la competencia, facilitando actualizar el contenido de la forma necesaria.

En definitiva, una herramienta de extracción de entidades con IA puede ser un activo valioso para las empresas que buscan mejorar sus esfuerzos de SEO.

A continuación te dejamos algunos recursos adicionales:

Alvaro Peña de Luna

Co-CEO y Head of SEO de iSocialWeb, una agencia especializada en SEO, SEM y CRO que gestiona más de +350M de visitas orgánicas al año y con una infraestructura 100% descentralizada.

Además de la empresa Virality Media, una empresa de proyectos propios con más de 150 Millones de visitas activas mensuales repartidos entre diferentes sectores e industrias.

Ingeniero de Sistemas de formación y SEO de vocación. Aprendiz incansable, fan de la IA y soñador de prompts.