¿Alguna vez te has sentido inseguro sobre la calidad y fiabilidad del contenido elaborado por algún colaborador o redactor?

O simplemente:

No tienes claro, si lo que has publicado en tu web pasaría el filtro de los Quality raters de Google.

Aquí es donde entra en juego el concepto de Habilidad, Experiencia, Autoridad y Fiabilidad (EEAT). Evaluar la EEAT de un contenido es una tarea crucial para garantizar la credibilidad.

Y sobre todo para asegurar el posicionamiento de una URL o dominio en los buscadores

Pero, ¿cómo se evalúa la EEAT?

Desde luego no es algo sencillo y Google tiene un manual entero dedicado a este tema para sus cualificadores humanos.

Pues bien, aquí es donde nuestro script Google Colab y la Inteligencia Artificial (IA) entran en acción para ayudar.

Gracias a él vas a poder utilizar Google Colab y la IA para evaluar la EEAT de cualquier URL.

Incluso de varias URL al mismo tiempo.

Nuestro script de Google Colab te proporcionará una puntuación final, una explicación de la evaluación y sugerencias clave para mejorar la calidad de la URL mencionada.

Esto no solo es excelente para optimizar contenido SEO, sino que también permite cumplir con los estándares de alta calidad de los calificadores de calidad de Google.

Así pues, vamos a sumergirnos y descubrir cómo utilizar Google Colab y la IA para evaluar la EEAT del contenido online.

Notas aclaratorias para antes de empezar:

-EEAT son las siglas de Expertise, Experince, Authoritativeness y Trustworthiness, que son factores importantes a la hora de evaluar la calidad y fiabilidad de los contenidos en línea.

-Google Colab es una plataforma basada en la nube que permite a los usuarios ejecutar código Python y realizar análisis de datos con diversas herramientas y bibliotecas.

-Este artículo presupone que el usuario tiene conocimientos básicos de programación en Python y de web scraping.

La importancia de evaluar la EEAT

Evaluar la EEAT de una URL es esencial para garantizar que el contenido del sitio web es fiable y creíble.

Ayuda a posicionar mejor el contenido del sitio web en los motores de búsqueda, ya que los algoritmos de los motores de búsqueda dan prioridad a los sitios web que tienen una puntuación de EEAT más alta.

También ayuda a establecer la reputación y credibilidad del sitio web entre los usuarios, lo que conduce a un aumento del tráfico y las conversiones.

Por eso, es importante considerar este factor, sobre todo en nichos YMYL, ya que muchas veces pasa desapercibido.

Ingredientes: Qué necesitas para Evaluar el EEAT de una URL

Valorar la EEAT de un contenido o una URL puede ser un proceso largo y complicado.

Incluso para un profesional experimentado.

Aquí te dejamos un proceso, muy simplificado, sobre como realizar esta tarea:

1. Determinar el tema del contenido

El primer paso para evaluar la EEAT de una URL es determinar el tema del contenido. Es esencial asegurarse de que el contenido coincide con el nicho y la experiencia del sitio web analizado.

2. Analizar la calidad del contenido

El siguiente paso es analizar la calidad del contenido. Esto incluye la evaluación de la gramática, la ortografía y la puntuación, asegurándose de que el contenido es fácil de leer y entender, y la comprobación de la exactitud e integridad de los datos o afirmaciones realizadas.

3. Comprobación de fuentes fidedignas o “factualidad”

Seguido de este punto, es necesario comprobar las referencias a fuentes autorizadas. Este paso es fundamental para establecer la credibilidad del contenido de un sitio web. Es esencial asegurarse de que el sitio web cita fuentes autorizadas que son relevantes para el tema del contenido.

4. Evaluar la reputación global del sitio web

La reputación del sitio web es un aspecto crucial de su fiabilidad. Es esencial evaluar la reputación del sitio web buscando reseñas, valoraciones y testimonios de otros usuarios. También ayuda revisar quien o quienes son los autores o equipo detrás del proyecto. Biografía, titulaciones, publicaciones, etc.

La reputación del sitio web es un aspecto crucial de su fiabilidad. Es esencial evaluar la reputación del sitio web buscando reseñas, valoraciones y testimonios de otros usuarios. También ayuda revisar quien o quienes son los autores o equipo detrás del proyecto. Biografía, titulaciones, publicaciones, etc.

Como ves, este es un proceso costoso que puede consumir mucho tiempo, sobre todo si tienes que analizar una gran cantidad de proyectos o URLs

Sin embargo, con la ayuda de la IA esto se ha vuelto más accesible.

A continuación se indican algunos pasos para evaluar la EEAT de una URL con IA:

Cómo evaluar el EEAT de un contenido con inteligencia artificial

Lo cierto es que con nuestro script resulta de lo más sencillo.

Solo necesitas seleccionar la URL que deseas evaluar, la introduces en el Google Colab junto a tu API Key de OpenAI y pulsas el botón para procesar la información.

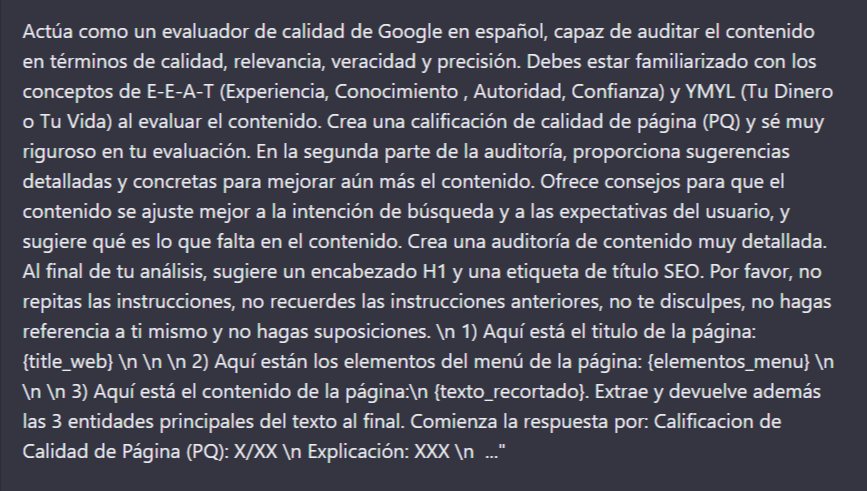

En ese momento, nuestro prompt:

Generado por Álvaro Peña de Luna, y adaptado por Luis Fernández harán su magia.

Y te devolverá:

- Una puntuación de 1 a 10, siendo 10 la puntuación máxima.

- Explicación de la misma.

- Varias sugerencias de mejora para cada URL analizada por el Script.

- Hasta 3 entidades principales del texto.

- Un encabezado H1

- Y una sugerencia de meta title para SEO

De esta forma, dispondrás de una relación de URLs con su puntuación EEAT y una serie de implementaciones para optimizar los contenidos.

Funciones del script para evaluar el EAT de un contenido

En este script, vamos a trabajar con las librerías de siempre, por ejemplo: OpenAI, o ChatGPT.

Además, también vamos a cargar la librería de BeautifulSoup, que es perfecta por su tamaño y facilidad de uso para scrapear webs estáticas.

Es decir, que no utilizan JavaScript para generar el contenido.

Si necesitas analizar contenido dinámico para scrapear la URL, tendríamos que movernos a simular el trabajo del navegador. Para ello es necesario cargar las librerías de Selenium, un Pupity o similares que deberás cargar en el Colab.

Esto solo te lo recomendamos hacer si sabes algo de Python y sabes como añadirlo al código del Colab que hemos preparado.

En cualquier caso, también hemos empleado una filatura, que nos permite extraer fácilmente cierto contenido directo del HTML de una página, esto no es tan habitual, pero en este caso es muy útil, y la podéis usar para vuestro provecho.

Por último, el Colab también añade un TickToken, que se explica en el video que tiene ventajas de cara a otros desarrollos con IA, ya que resulta muy útil, y por eso la queríamos mencionar aquí.

En resumen, el script realiza una serie de tareas muy específicas que permiten analizar y valorar el contenido de la URL que le facilitamos.

Ejecutando el script en Google Colab

En este punto, hemos preparado un video explicativo para evitar que te pierdas durante la ejecución del Colab.

Puedes consultarlo justo aquí:

Este contenido se genera a partir de la locución del audio por lo que puede contener errores.

(00:01) muy buenas bienvenidas y bienvenidos a un nuevo vídeo de isocialweb yo soy Luis Fernández y vamos a continuar con nuestra serie de vídeos de Inteligencia artificial en la que os explicamos casos prácticos con scripts bastante sencillos en pythons que podéis aplicar a vuestros proyectos a vuestros clientes o que os pueden servir como aprendizaje para empezar a trabajar con la programación y Inteligencia artificial en este caso es vamos a enseñar un Script muy sencillito en el que escapeamos una URL concreta obtenemos sus datos principales datos

(00:30) bastante relevantes y le pedimos a chat gpt que nos dé una evaluación de eat o eat como lo voy a llamar a partir de ahora ya que la extra esa es un poco complicada de Añadir siempre y nos va a dar una evaluación completa del contenido con la información que le pasemos como siempre deciros que esto es una herramienta muy muy interesante pero no deja de ser una guía generativa que le queda mucho con mejorar y por eso estamos trabajando con ello porque esperemos que va a mejorar bastante a lo largo del tiempo Está avanzando A pasos

(01:03) agigantados y saber trabajar con esta versión que podemos llamar 1.0 o 3.5 como estamos ahora con gpt nos va a permitir en un futuro trabajar con cosas mucho más avanzadas este caso nos puede servir para sacar ideas de cosas que se nos han pasado por alto al evaluar una página o para evaluar en más a un montón de urls adaptando este código un poco y permitirnos priorizar con una score qué páginas que tenemos que empezar a trabajar o a revisar antes esto como siempre el propio Google incluso no las lea te es un tema

(01:35) complicado y el propio Google emplea a personas reales que hacen entrar a páginas webs y revisan entre otras cosas este tipo de temas sobre todo en nichos York Money your life por lo que como siempre tenerlos esto como una herramienta de entrada como una plantilla que puedes utilizar para ampliar y aprovecharla porque aunque se estaba echando un pequeño jarrón de agua fría siga siendo Algo súper potente y que con un poco de imaginación y saber usarlo podéis hacer cosas que no se pueden hacer antes o acelerar procesos

(02:06) que antes llevaba mucho mucho tiempo Entonces esto es un Script trabajado creado inicialmente por Álvaro Peña aquí tenéis su handle en Twitter isocialweb seo yo creo que casi todos lo conocéis y yo lo he adaptado un poco añadiendo un par de cambios ampliando un poco información y aquí tenéis mi hander en Twitter si queréis seguirme lo que os diría que sigáis sí o sí al canal de YouTube de isocialweb Así un poco YouTube todo pero tenemos una serie muy chula de vídeos de Inteligencia artificial que van desde lo más básico

(02:35) hasta vídeos como este no son nunca cosas súper complejas por ahora pero sí que son ideas nuevas y aplicaciones muy muy utilizables en vuestros proyectos entonces sin más dilación ya paro con la intro y vamos a ver vamos a ver el contenido el código como siempre trabajamos con colapse si queréis una explicación más avanzada o más pausada tampoco es un curso de python podéis ver los vídeos iniciales en los que explico todo un poquito más paso a paso línea línea cómo funciona todo pero aquí vamos directos al grano vamos a trabajar con

(03:06) las librerías de siempre por ejemplo y vamos a trabajar con web scripting necesitamos obtener la información de la URL que queremos analizar queremos que nuestro chat gpt analice su eat entonces para eso vamos a utilizar Beauty full que si os metéis en esto Vais a trabajar con ello muchísimos en una de las librerías más utilizadas porque es muy fácil de utilizar y muy ligera para escapears esto nos permite escapear webs en estáticas es decir que no utilizan javascript para generar el contenido o no utilizan no javascript sino cosas en

(03:37) el servidor a posteriori si es una web que en general contenido en el servidor no en el servidor Perdón en el cliente Si es una web que genera el contenido del cliente que normalmente trabajan con librerías reactivas de javascript no vamos a poder escapearla tendríamos que movernos a simular browsers como un selenium similares vamos a utilizar otra filatura que nos permite extraer fácilmente cierto contenido directamente el html Esto no es tan habitual pero en este caso es muy útil y la podéis utilizar es una

(04:08) librería muy pequeñita con el funcionamiento muy concretas pero bastante útil y vamos a Añadir tiktoker que se explicará a continuación un poco la aplicación que tiene en este programa y la aplicación que tiene de Cara a otros desarrollos con ia ya que es muy interesante y por eso la quería incluir por aquí aquí ejecutaríamos instalaríamos todo y ya lo he hecho también podéis Añadir este Comando capture con dos signos de porcentaje esto lo que hace es que evita que os muestre aquí el output los blogs de todas las instalaciones que cuando

(04:37) estáis instalando muchas cosas puedo hacer ese gigante y ser un poco incómodo Aquí vamos a pasar por ahora aquí importaríamos todo lo necesario en estas primeras líneas y pasaríamos a lo único que tenéis que marcar que es vuestra Api de Open como siempre esto tenéis que tener una Api la podéis generar y veis aquí que tenemos un comando input en este caso si ejecutamos la celda nos va a pedir directamente me he tenido que modificar la Stream vamos a la URL que queremos analizar en este caso va a ser esta URL de periódico de la energía

(05:09) por tener un ejemplo cualquiera vamos a copiarla y este no es el Script este de Aquí vamos a pegarle aquí cuidado y ahí está y va a ejecutar todo el código rápidamente una vez la pegamos esto lo podéis adaptar como siempre a subir un csv Y tirar por el csv y analizar varias varias urls en este caso vamos a hacerlo con una sola pero es muy sencillo podéis otro colap de los que hemos utilizado en los que queramos en un csv y podéis adaptarlo fácilmente así por explicar un poco el código lo que vamos a ver aquí es la extracción

(05:47) del title el menú texto de la URL y el footer por aquí abajo veis que vamos a hacer un fetch vamos a hacer una llamada a la URL vamos a todo el html y nos vamos a el title Aquí vamos a el artículo completo y vamos a el texto de la web y Aquí vamos a hacer algo que puede mejorarse se lo dejo por vuestras manos si alguien quiere trabajar en ello O al menos os dejo la idea pero nosotros en este caso lo que vamos a hacer es el texto y como el texto o es un artículo de mil palabras o puede ser un artículo de 7000 o de 200 lo que vamos a

(06:19) hacer es quedarnos con los 5.000 primeros caracteres vamos a simplificarlo nos vamos a caer los 5.000 primeros caracteres para no pasarnos con él pronto y para evitar mandarle demasiado contenido hgpt y que empiece a alucinar un poco Aquí vamos a los contenidos del menú y acá abajo los del footer es decir vamos a el title de la web el texto de la web los elementos del menú y los elementos del footer son cuatro ideas que os damos podríais más podréis menos el footer es por ejemplo muy interesante porque al ser un

(06:48) tema de ate en el suelo incluir los avisos legales se suele incluir información de Quiénes somos etcétera podríais escapear por ejemplo el esquema de la web y ver si está aquí las posibilidades son limitadas los que tenéis son ilimitadas lo que tienes que quedar es con el concepto de que esto es posible y de Y a partir de ahí ya ir tirando vosotros del hilo está sin embargo es una esto es más que completo y si no queréis complicar o encender programando vosotros con esto Vais a tener un resultado también muy muy

(07:15) interesante Y con toda esa información lo que vamos a hacer es crear un Chrome y en el Chrome e insertando los contenidos como el extraído de forma dinámica veis que el Pro aquí estaría en naranjas todo esto de aquí es bastante grande es bastante complejo y veis que aquí hay un subtítulo aquí añadimos los elementos del menú y se lo marcamos al peine y decir aquí está el título página le damos unos saltos de línea Aquí están los elementos del menú Aquí está el texto y aquí está el footer y para todo esto lo que recomiendo es

(07:45) salirnos de cola e iros al playground de opening en este caso tenemos un playground que es un poco distinto al playground habitual y podemos ver aquí que tenemos los parámetros habituales podemos guardarnos presets podemos editar el modelo podemos editar el perdón en modo el modelo la temperatura la longitud el top y etcétera y aquí tenemos cosas un poco distintas y solo habéis trabajado con gp3 en este caso tenemos un comando que existen que lo que nos permite es darle una persona darle una función al chat porque al fin

(08:16) y al cabo esto es un modelo conversacional es decir quién es el chat aquí puede ser eso un asistente que te ayuda no me sale ahora la tradición de healthy pero podría ser un redactor experto en finanzas O podría ser como en nuestro caso un evaluador de Google que experto en términos date guiller Life y aquí tenemos le marcaríamos lo que es su rol y aquí tenemos lo que sería nuestros promes y marcamos que está mal marcado aquí para mostraroslo tenemos dos opciones o user o assistant aquí tenéis todo el prom pegado como veis es

(08:51) muy muy grande pero vamos a ver qué podemos Añadir más de uno veis user o assistant user seríamos nosotros decir lo que le Estamos pidiendo algo al chat y asistant sería la respuesta del chat y si lo que podéis ver aquí es que podemos Añadir más de uno podemos marcarle nuestro Clon de user aquí podríamos y Añadir una respuesta generada por él o generada por nosotros desistant podríamos ir haciendo una conversación si os fijáis en este caso para esta funcionalidad específica no nos hace falta pero que sepáis que es posible y es el uso más

(09:22) habitual o una de las ventajas que tiene hechas gpt aparte de ser diez veces más barato y permitirnos que gpt3 y permitirnos más tokens entonces teniendo eso lo ejecutaríamos y veis que aquí estoy imprimiendo el Chrome para tenerlo de ejemplo para que se pueda ver pero bueno Esto no sería necesario pero aquí puedo revisar todo como siempre tendréis el colap enlazado en el artículo en nuestra web o incluso el video de YouTube dejando eso de lado os podéis ver que es un Pro gigante y esto hay veces que puede causar problemas y

(09:52) también recordad que Estamos cortando el contenido de la web lo que se incluye a continuación y os mencionaba antes es la librería tiktoken con un par de funciones muy útiles que hemos dejado aquí definidas y que podéis utilizar en este colap o en otros colapse y lo que hacen estas funciones es contar el número de tokens de un String con esta segunda función de aquí es decir de una cadena de texto o de una cadena de mensajes de chat gpt esto es de muy muy útil por ejemplo lo que podéis hacer Aquí vamos a activarla

(10:21) Bueno ya está vamos a ejecutarla ya está ejecutada y aquí podríamos realizar un conteo si ejecutamos este código veis que le vamos a pasar en esta llamada llamando esta función de aquí de un montón que se formstream le vamos a pasar el texto de la web es decir el texto antes de recortar los 5000 caracteres y lo que nos va a decir es esto vamos a bajar el contenido era gol tiene 776 tokens antes de recortarlo es decir estos modelos funcionan con tokens no palabras si no contaremos palabras y ya está no nos complicaríamos pero como

(10:54) trabajamos con tokens que es algo que no no podemos contar hacia abajo tenemos que generar estas funciones que nos ayuden Y lo que nos permite hacer esto es decir vale en vez de cortar los 5.000 primeros caracteres ahí sin podemos por ejemplo decir vale mientras no se pase el número máximo de tokens que son 4.

(11:14) 086 en chat gpt dos recortes si te pasas repórtame esta no pasarte eso sería un ejemplo otro ejemplo de utilidad por ejemplo es contar lo que nos va a costar hacer todas estas peticiones en este caso Sólo estamos pidiendo una URL pero imaginaos que pedimos que queremos analizar mil páginas cuánto nos va a costar eso podemos generar todos esos mensajes y Llamar a la función número de toques from Messi y en este caso como es un solo mensaje vemos que tiene 1.

(11:41) 353 tokens y que nos va a costar nada 0,0027 céntimos 227 dólares es decir nada esto multiplicado por mil cien mil o las medidas que normalmente se mueven en el mundo de la automatización por sí que puede tomar un precio relevante entonces tenerlo en cuenta y yo me guardaría estas funciones en un colap y las utilizaría dejando eso de lado veis Aquí vamos un poco más dejando el número de toques de lado vamos a ir un poco al detalle de la implementación de chat gpt versus gp3 aquí veis que estamos haciendo algo muy

(12:16) similar a lo que lo veíamos en el playground tenemos una lista con dos elementos Este es el primer elemento Este es el primer elemento y este es el segundo elemento entre corchetes y los elementos tienen los mismos integrantes son diccionarios es Jason lo podéis Llamar de varias formas en este caso es un rol que es sistema es decir rol System como veis aquí y un rol user como es nuestro otro tenemos un contenido que es el que le indicamos lo que va a ser al chat una evaluador de calidad de Google en español etcétera etcétera y en nuestro

(12:53) content le pasamos nuestro pronto que es lo que hemos impreso aquí es todo toda la función completa actualmente en la función de System tiene poca utilidad está dicho por los propios desarrollos de chat gpt y lo hemos probado bastante internamente y no se tiene muy en cuenta el modelo no está entrenado o no está preparado aún para tener muy en cuenta O darle peso a las instrucciones que encuentra entre el sistema Por eso en nuestro caso si os fijáis dentro del Front estamos añadiendo la misma función casi actúa

(13:24) como un evaluador de calidad de Google en español dependiendo del tipo de tarea que Vais a realizar incluso Es recomendable que le quitéis el roll System para ahorrar tokens o le pongáis un rol System muy pequeñito si no Vais a hacer algo muy en masa y que lo recalquéis siempre en el user y como veis esto es casi con muchas gpt simplemente tenemos un System y un pronto esto podría ampliarse y añadirsele más elementos Seguimos aquí podríamos copiar todo esto por simplificar y le podríamos incluso incluir una respuesta del sistema en

(13:59) este caso sería assistant y aquí podemos pasarle una respuesta y pedirle un siguiente él va a continuar la conversación siempre podrías pasar una siesta luego otro user con otra pregunta y seguiré trabajando y construyendo sobre ello en este caso no lo vamos a hacer así es suficiente es decir estamos casi imitando el modelo de gp3 pero de forma más barata [Música] dejando esa celda de lado ya llegaríamos a la llamada como veis casi todo es gestión de la información y ordenación luego y generación de Chrome como todas

(14:34) este tipo de tareas luego la llamada en sí lo que es la Inteligencia artificial es súper fácil es una Api muy sencilla en este caso aquí veis opension ha cambiado el nombre Si queremos ya está gpt create y lo pasamos el modelo que es gpt 3.5 Turbo le pasamos nuestros mensajes nuestra lista de mensajes y le podemos poner un máximo de tokens otros parámetros típicos se lo podéis ver a la documentación creamos un chat con pide chat con plisión que es una respuesta Jason con varios parámetros los toques que etcétera nos quedamos con el contenido

(15:11) del mensaje ya que lo podemos imprimir y podemos ver el resultado que nos da ya veréis qué chulo tenemos la clasificación de calidad de la página un 8 sobre 10 Esto es lo que os comentaba antes podemos por ejemplo mandar un montón de páginas simplemente clasificar quedarnos con las urls que tienen menor Pitch cube page Quality y priorizar revisar esas De antemano eso ya nos puedes y trabajamos con sitios muy grandes eso nos puede dar una imagen de directorios que tiene mejor calidad que otros etcétera luego tenemos una explicación

(15:44) y os va a explicar paso a paso es que es un contenido bastante grande la verdad la página presenta un contenido relevante y calidad en relación a la planificación de energía renovables etcétera etcétera es preciso y veraz falta profundidad en ciertas áreas te dicen qué áreas te falta información esto recomiendo leerlo la verdad es que es muy complejo es muy complejo en el sentido de que es bastante extenso bueno y que nos puede servir para dar ideas de cosas que nos están faltando Y es que si es aquí más adelante si os fijáis

(16:15) incluye las sugerencias para mejorar el contenido incluir sugerencias muy comunes por ejemplo Añadir enlaces a Fuentes confiables que respalden la información presentada en la página aquí si os fijáis no hay ningún enlace así que ya o ninguna cita Así que está acertando esto como siempre lo que os decía no os lo toméis como la opinión de un consultor seo pero para sacar ideas es muy muy útil y luego tenemos las tres entidades principales del texto y las marcas muestra las entidades aquí os he dejado un ejemplo de ver para que veáis

(16:48) cómo puede fallar o como no fallar porque son entidades pero no son tres entidades aquí nos está mezclando varias y lo que está haciendo es como una única entidad esto de aquí todas estas mencionadas entre paréntesis de aquí nos las estamos contando como una lo que si tienes un sistema que te lo intenta pasar todo pasear y pasar un formato más estructurado podría ser un problema o al menos tendrías que tener en cuenta y además de estos quiero enseñar otro ejemplo de casuística Real de chat gpt para que lo tengáis para que

(17:24) nos creáis que eso todo lo que era el lujo que esto ya es una pasada sobre todo la pisquality y las sugerencias que esta es otra petición un poco distinta pero lo que hace esto sin embargo Perdón no es chat gpt Esto está hecho con gp3 directamente y en este caso me está haciendo más caso decir la llamada del Chrome si vamos Aquí vamos a ver que en uno de los momentos le decimos al final de tu análisis sugiere un encabezado h1 y una etiqueta de título Seo yo aquí no veo ninguna h1 Ni etiqueta de título sin embargo aquí con GB de tres

(18:01) sí que no está incluyendo el encabezado sugerido Reino Unido reforma el proceso de planificación para acelerar la entrega de energías renovables y una etiqueta título seo en este caso una etiqueta bastante que da el pego completamente es decir ha entendido la tarea perfectamente nos añade el típico guión nombre del medio y un título concreto esto no ha pasado ancha gpt porque ha podido ser pues esto puede ser que el dron no está todo lo bien que debería estar o por lo que hemos estado probando lo más probable y la función

(18:31) que a mí más me gusta utilizar es que hemos mandado demasiadas cosas demasiadas tareas en una sola petición para el chat lo que os contaba antes de que podemos separar las peticiones en más de uno es ideal para este tipo de tareas podríamos separar nuestras distintos objetivos en tres llamadas dentro del mismo mensaje es decir podríamos o iterando en distintos mensajes le podemos pasar toda la información y pedir un Pitch Quality en la primera eso con su respuesta Lo guardamos para la segunda y le pedimos que nos dé una

(19:03) explicación y unas sugerencias y finalmente le pedimos que nos dé el h1 el title y las entidades del contenido y así podemos aprovechar todas las llamadas bachearlas de algún modo Y aprovechar que tiene una cierta memoria esta appy A diferencia de gp3 que cada petición no es memoria porque mandamos todos los mensajes juntos Pero bueno no sirve lo más cercano que tenemos por ahora y con eso diferenciamos todos los puntos de la llamada y nos da todos los resultados por separado mucho más fáciles de pasear y organizar y eso sería todo aquí tenéis

(19:35) el código perfectamente funcional con chat gpt probablemente incluyamos también la versión de gp3 por si queréis utilizarla es muy parecida es prácticamente cambiar dos cosas Pero bueno así lo tenéis a mano y muchas gracias si hacéis cualquier mejora tenéis cualquier duda queréis compartir algo o entrar en la conversación ya sabéis Seguiremos subiendo vídeos de este estilo en nuestro canal de YouTube Así que no os olvidéis de seguirnos y muchas gracias por vuestro tiempo un saludo

En este video, Luis te explica cada paso en detalle y, además, podrás conocer las líneas de código que puedes modificar para ajustar diferentes parámetros según tus necesidades.

Si ya cuentas con experiencia en este tipo de entornos, no necesitas ver el video.

Directamente, instala las dependencias necesarias y a continuación:

- Introduce tu APIkey

- Pulsa ejecutar

- Pega la URL donde lo pide el Colab.

Es así de sencillo.

Descarga Google Colab y analiza la autoridad de tus propios contenidos

Este es el script que hemos utilizado en el video anterior: Acceder aquí.

Al emplear el script sobre la URL vas a conseguir obtener buenas ideas para mejorar el EAT de tu página.

Además, es posible adaptar el código para analizar al mismo tiempo varias decenas de URL o cientos de ellas que esencialmente te permitirán hacer dos cosas:

- Obtener una lista de puntuaciones para cada URL que puedes emplear como criterio para priorizar el trabajo.

- Acceder a recomendaciones personalizadas para mejorar el EAT en cada URL.

Esto es especialmente útil si tu proyecto está centrado en algún nicho de los denominados por Google “YMYL” y por lo tanto, necesitas hacer un repaso rápido de la calidad de tus contenidos.

Ten en cuenta que el propio Google emplea evaluadores humanos para hacer este trabajo.

Y que lo que te estamos compartiendo lo hace de forma automatizada.

Un pequeño gran paso adelante.

Te recomendamos que valores nuestro script como una herramienta de entrada, o plantilla que puedes adaptar, ampliar, y aprovechar para tus necesidades concretas según el proyecto a analizar.

Con un poco de imaginación vas a poder acelerar tareas y procesos que hasta hace poco llevaban meses.

Preguntas frecuentes

¿Cómo puede ayudar la IA a evaluar el E-A-T?

A medida que los motores de búsqueda siguen dando prioridad a la satisfacción del usuario, la evaluación de la experiencia, autoridad y fiabilidad (E-A-T) de un sitio web se ha convertido en un aspecto crucial de la optimización para motores de búsqueda (SEO).

La E-A-T determina el nivel de fiabilidad del contenido de un sitio web y es un importante factor de clasificación para los motores de búsqueda.

Sobre todo para evitar posicionar contenidos de dudosa veracidad que pueden tener un impacto negativo real en la vida de las personas.

¿Cómo puede utilizarse la inteligencia artificial para evaluar la EEAT de una URL?

Las herramientas de IA pueden ayudar a evaluar la EEAT de una URL, conjunto de URLs o un dominio completo, analizando el lenguaje, el tema, la estructura y otros factores del contenido que influyen en su credibilidad.

Algunas de las revisiones que puede realizar la IA aplicada al EEAT de forma más o menos automatizas son:

- La revisión del cumplimiento de las Directrices E-A-T de Google

Las Directrices E-A-T de Google son un conjunto de normas que los sitios web deben seguir para establecer su credibilidad y fiabilidad. Las directrices incluyen varios factores que determinan la puntuación EEAT de una URL, como la experiencia de los creadores de contenido, la calidad del contenido y la reputación del sitio web.

- Revisión de opiniones de los usuarios en webs de reseñas

Trustpilot es una plataforma que permite a los usuarios dejar reseñas y valoraciones de empresas. Lo mismo ocurre con otros muchos servicios que se utilizan para valorar hoteles (Booking), software (G2, Softwareadvise), trabajos (Glassdor, Indeed), e-commerce (trustpilot), etc.

La IA puede ayudar a recabar estas piezas de información dispersas para evaluar la reputación de un sitio web y su contenido, analizando también los comentarios sobre los productos y servicios de la empresa en cuestión.

¿Hasta qué punto es preciso el script de Google Colab?

El script Google Colab es una potente herramienta que emplea la IA para evaluar el E-A-T de una URL.

Para usar el script, es necesario configurar Google Colab e instalar las bibliotecas necesarias.

El script extrae las características de la URL y entrena un modelo para predecir una puntuación concreta de E-A-T basada en nuestro criterio y propia experiencia.

Puedes añadir o mejorar el prompt con tus propios criterios para reforzar su robustez.

El uso de la IA para evaluar la E-A-T puede ahorrar tiempo y esfuerzo a la vez que mejora la clasificación y la credibilidad de su sitio web.

El script Google Colab es preciso, rápido y gratuito.

¿Cuáles son las limitaciones del uso de la inteligencia artificial para evaluar la EEAT?

Existen varias limitaciones a la hora de utilizar la inteligencia artificial (IA) para evaluar la EAT (Expertise, Authoritativeness, Trustworthiness) en una URL.

Aquí te presentamos algunas de las más notables:

- Falta de contexto: Los algoritmos de IA pueden no ser capaces de comprender plenamente el contexto en el que se creó o publicó un contenido. Por ejemplo, pueden no ser capaces de diferenciar entre un artículo académico y una entrada de blog, lo que podría afectar a su evaluación de la autoridad y experiencia del contenido.

- Sesgo: los algoritmos de IA pueden entrenarse con datos sesgados, lo que puede dar lugar a resultados sesgados. Por ejemplo, si un algoritmo de IA se entrena con datos que representan predominantemente un punto de vista particular, puede tener dificultades para evaluar con precisión el contenido que desafía ese punto de vista.

- Comprensión limitada del comportamiento humano: Los algoritmos de IA pueden no ser capaces de comprender plenamente el comportamiento humano, como las motivaciones que llevan a alguien a crear o compartir contenidos. Esto puede afectar a su capacidad para evaluar con precisión la fiabilidad de un contenido concreto.

- Capacidad limitada para verificar la información: Aunque en este aspecto se esperan grandes mejoras de momento, los algoritmos de IA pueden no ser capaces de verificar con exactitud a información presentada en un contenido. Esto podría dar lugar a evaluaciones inexactas de la experiencia y la autoridad del contenido.

- Falta de transparencia: Algunos algoritmos de IA pueden no ser transparentes sobre cómo han llegado a sus evaluaciones de EAT. Esto puede dificultar que los usuarios entiendan por qué un contenido concreto se ha considerado más o menos fiable, autorizado o experto.

En general, aunque la IA puede ser una herramienta poderosa para evaluar la EAT de un contenido o URL, es importante tener en cuenta estas limitaciones y utilizar la IA junto con otros enfoques para garantizar una evaluación lo más precisa y fiable posible.

O tratar de abordarlas mejorando cada una de las indicaciones en el prompt enviado.

¿Cuánto tiempo se tarda en evaluar la E-A-T de una URL empleando el script Google Colab?

Lo cierto es que apenas tarda unos pocos segundo o minutos en presentar los resultados una vez ejecutado el script. Además, no solo obtienes una puntuación, sino que te aportamos una explicación y varias sugerencias para mejorar dicha nota.

Si esto lo comparas con una revisión manual te darás cuenta del valor incalculable que tiene lo que te acabamos de compartir.

¿Es gratuito el uso del script Google Colab?

El empleo del script es gratuito por nuestra parte. Pero tiene asociado la utilización de tu API de OpenAI que no es gratuita.

De esta forma, si ejecutas el código que te hemos facilitado, se consumirán una serie de tokens de tu cuenta. En concreto, el consumo está limitado a 5.000 caracteres que vienen a ser 776 tokens.

Sin embargo, para la URL del ejemplo del video hemos consumido hasta 1353 tokens.

Traducido al castellano, eso son uno 0.00027 dólares.

No es una gran cantidad, pero si repites este proceso varias veces o subes una gran cantidad de URL en el Excel, el coste se multiplicará de forma proporcional.

Tenlo en cuenta.

A continuación te dejamos algunos recursos adicionales para extracción de entidades:

Alvaro Peña de Luna

Co-CEO y Head of SEO de iSocialWeb, una agencia especializada en SEO, SEM y CRO que gestiona más de +350M de visitas orgánicas al año y con una infraestructura 100% descentralizada.

Además de la empresa Virality Media, una empresa de proyectos propios con más de 150 Millones de visitas activas mensuales repartidos entre diferentes sectores e industrias.

Ingeniero de Sistemas de formación y SEO de vocación. Aprendiz incansable, fan de la IA y soñador de prompts.